2. 煤矿智能化与机器人创新应用应急管理部重点实验室, 北京 100083;

3. 中国矿业大学(北京)智慧矿山与机器人研究院, 北京 100083

2. Key Experiments of the Ministry of Emergency Management for Intelligent and Robotic Applications in Coal Mines, Beijing 100083, China;

3. Institute of Intelligent Mining and Robotics, China University of Mining and Technology (Beijing), Beijing 100083, China

0 引言

SLAM的概念是1986年SMITH和CHEESEMAN等在国际机器人与自动化大会上提出来的[1]。通过机器人自身移动并结合其搭载的感知传感器对未知环境的观测数据,SLAM算法构建未知环境地图并获取机器人在所构建地图中的位姿信息,进而实现机器人自主移动。随着移动机器人的应用升级、场景普及智能驾驶应用的需求,SLAM作为移动机器人自主定位领域中的关键问题之一[2]正在被广泛研究。

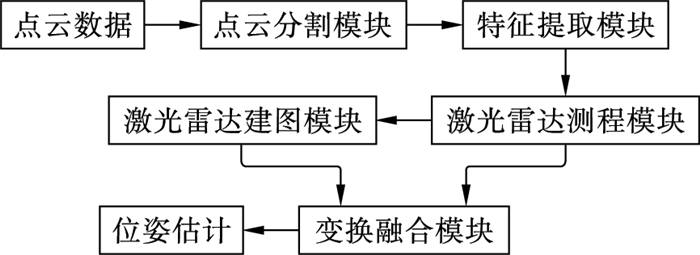

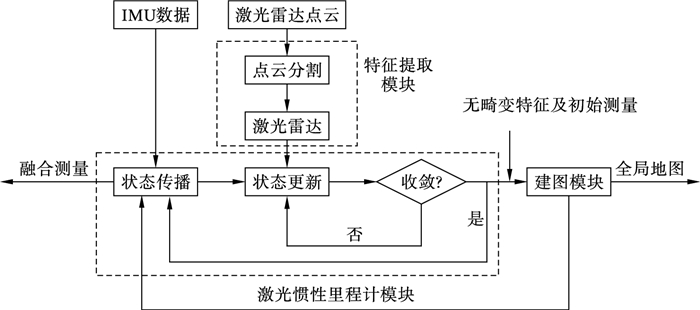

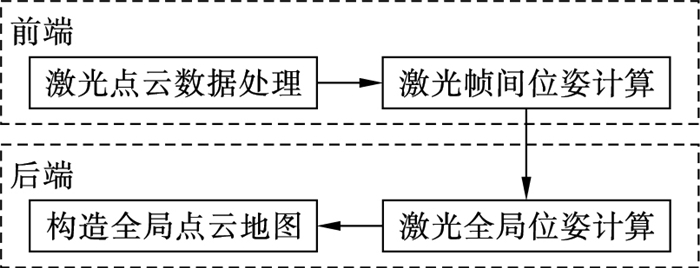

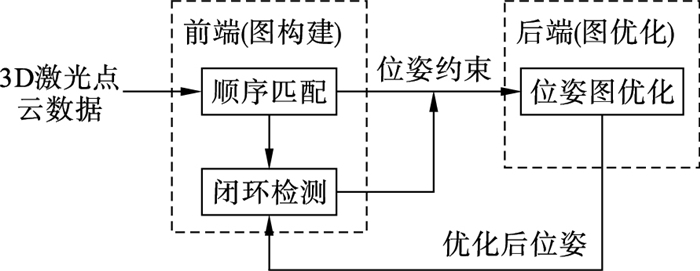

SLAM算法的经典框架包括前端数据关联和后端优化两部分[3],如图 1所示。前端依据激光雷达测得的点云数据,通过扫描匹配进行帧间配准,闭环检测以获得不同帧间点云数据的关系,不断更新位置估计,并存储相应的地图信息;后端通过维护和优化前端得到的机器人位姿和观测约束,得到所构建地图的最大似然估计与机器人当前位姿。

|

| 图 1 激光SLAM算法框架 Fig.1 Framework of laser SLAM algorithm |

根据所用传感器,SLAM算法大致分为基于视觉传感器的视觉SLAM算法和基于激光雷达的激光SLAM算法两种[4]。与视觉传感器相比,激光雷达具有测距精度高、不易受光照与视角变化等外部干扰和地图构建直观方便等优点,广泛应用于大型复杂室内外场景地图的构建。激光雷达按照激光线数不同分为2D激光雷达和3D激光雷达。目前2D激光SLAM技术发展较为成熟,已在服务机器人和工业现场得到了应用[5]。2D激光雷达同时发射和接受单线的激光,其结构简单、扫描速度高、角度分辨率高,功耗低且精度可达厘米级,但受限于平面环境而无法适用于全地形环境,在有起伏或者存在坡道等场景就不能实现定位和地图构建。3D激光雷达通过发射多束激光测量其与未知环境中物体的几何信息,获取包含精准的距离和角度信息的点云数据,体现3维空间结构信息,而且线数越多获得的激光点个数越多,对环境结构的描述也更清晰。

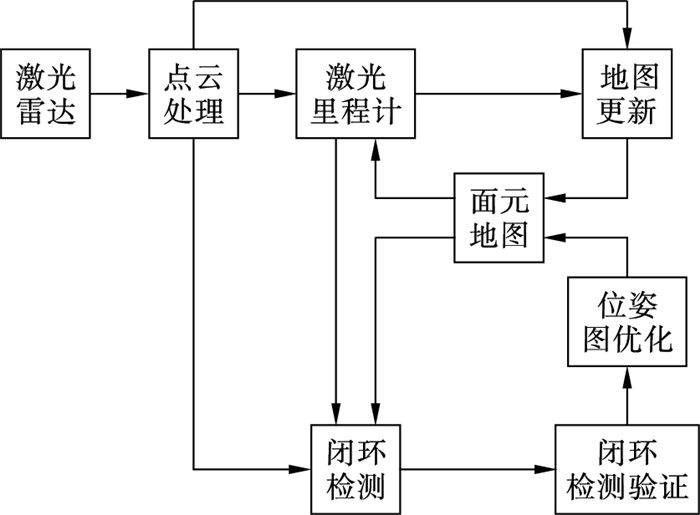

随着多线激光雷达的量产和普及,以及嵌入式处理器功耗降低和算力增强,3D激光雷达开始走向低成本、低功耗和高可靠性的应用,基于3D激光雷达的SLAM算法得到了迅猛的发展。ZHANG等于2014年提出的LOAM(LiDAR odometry and mapping) 算法[6]是目前最具代表性的3D激光SLAM算法。其原理是将激光SLAM分成里程计算法和地图构建算法,具有速度快、精度高、鲁棒性好以及计算消耗小等优点;缺点是没有闭环检测,大规模测试中会出现漂移,在空旷环境下会因特征缺少而出现退化问题。SHAN等[7]优化了LOAM的特征匹配,增加了闭环检测,提出了LeGO-LOAM(lightweight and groud-optimized LiDAR odometry and mapping),运行时间比LOAM算法减少了一个数量级,在占用计算资源减少的情况下实现了相似甚至更好的精度,但有时会出现错误或识别遗漏。有学者使用Eigen线性迭代和Ceres Solver非线性优化简化了代码结构,减少了复杂的数学推导和冗余操作,提出了LOAM的高级实现A-LOAM[8]。此外,DESCHAND等[9]提出了一个帧到模型的匹配框架IMLS-SLAM,引入隐式移动最小二乘(implicit moving least square,IMLS) 表面公式,采用最小化点到隐式表面距离的方法表示局域激光雷达的扫描点,从而提供了准确的姿态估计,但不能实时实现。作为一种典型的密集方法,BEHLEY等[10]提出了基于面元的地图进行配准和闭环检测的SuMa(surfel-based mapping)算法,对于缺失特征或缺失数据更具鲁棒性,仅基于激光点云数据就可以建立大规模环境下的全局一致性地图。

现有的3D激光雷达SLAM算法研究在公开数据集测试中表现出了良好的性能,平移或旋转的漂移较低,图像质量和轨迹的精度较高,但在实际应用中仍存在较多局限性:包括对环境的鲁棒性,例如从室内到室外或者从静态环境到动态环境;对实时性的要求,例如在一些无人地面车辆(unmanned ground vehicle,UGV)等机器人平台上,计算资源有限,而计算单元需要同时进行定位和路径规划,计算成本较高等。已有学者总结了SLAM的相关工作[11-13],描述了SLAM的一般问题、模型及框架、难点和主要方法,回顾了相关工作进展,并且讨论了SLAM的发展趋势,其中关于算法的进展多介绍视觉SLAM算法或SLAM算法的特定方面或其子领域,涉及3D激光雷达SLAM算法综述研究较少。周治国等[14]概述了3D激光雷达SLAM算法框架和关键模块,但是对于算法方案的介绍只选取了6种开源算法进行测试对比,并未详细展开。XU等[15]介绍了基于3D激光雷达的多传感器融合SLAM的发展过程和最新的研究工作。本文从3D激光SLAM算法的前端、后端,深度学习和多传感器融合在3D激光SLAM中的应用等方面,系统阐述现在主流的3D激光SLAM算法方案,探讨目前主流3D激光SLAM算法存在的问题和不足,总结其研究热点和发展趋势,以期为其后续研究提供借鉴和指导。

1 SLAM前端3D激光SLAM算法的前端主要解决数据关联的问题,扫描匹配考虑局部数据关系,而闭环检测则处理全局数据关系;扫描匹配与闭环检测都是根据激光帧数据建立节点间的约束。

1.1 扫描匹配算法扫描匹配算法的精度和计算效率直接影响着SLAM算法轨迹估计和地图构建的准确性,为后端优化提供机器人状态的初始值与约束关系,大致分为基于迭代最近点(iterative closest point,ICP)的、基于几何特征的及基于数学特征的匹配算法。

1) 基于ICP的匹配算法

经典ICP算法是1992年BESL等[16]和CHEN等[17]提出的。其原理为以距离误差最小为目标函数,通过迭代的方式寻找相邻扫描帧两扫描点间的最佳变换关系。该算法易陷入局部最优,且当扫描点数增多时,计算成本过高。

为了解决经典ICP算法易陷入局部最优的问题,提高效率和准确性,许多学者研究了基于ICP的改进算法,优化了ICP算法的步骤,包括点的选择、匹配、加权和剔除错误关联,或者最小化成本函数的选择。其中适合3D激光雷达SLAM的算法有PP-ICP[18](point-to-plane ICP)、PL-ICP[19](point-to-line ICP)、GICP[20](generalized ICP)、NICP[21](normal ICP)等。PP-ICP算法的误差代价为点对面的距离;而PL-ICP算法利用点到线的距离作为误差代价,更符合实际情况;GICP将ICP算法和PL-ICP算法相结合,在概率框架下进行点云配准,提高了适用性和精确度;为提高精度,NICP则考虑了环境曲面的法向量和曲率。

IMLS-ICP[9]为每个点分配一个权重值,选择具有代表性的点匹配;利用基于目标点的局部曲面法线,采用IMLS法重建曲面。BLAM[22]通过GICP算法初步计算两帧点云数据的位姿变换,获取当前帧对应的最近点,并再次利用GICP算法得到精确的位姿数据,执行闭环检测得到地图,提高了建图精度。LiTAMIN算法[23-24]将对称的K-L(Kullback-Leibler)散度引入到反映两个概率分布之间差异的ICP代价函数中,减少了点云配准的点数,提高了处理速度;使用K-D tree(K-dimension tree)的观点构建体素网格地图,保持配准精度的同时,提高了算法的准确性、鲁棒性。然而实现收敛所需的大量迭代、对良好初始化的要求以及对噪声的敏感性仍限制了ICP及其变体算法;而且应用原始点云匹配的计算成本通常很高。

2) 基于几何特征的匹配算法

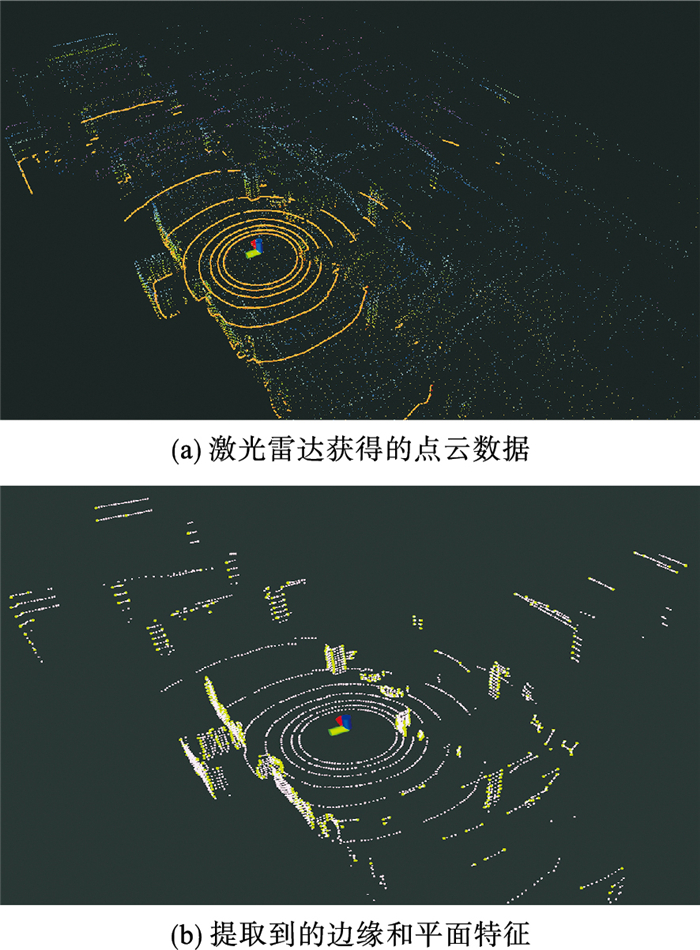

基于几何特征的扫描算法主要利用边缘和平面特征,并保持边缘和平面的匹配,如图 2所示。LOAM[6]基于局部平滑度提取当前帧和匹配帧的边缘和平面特征,并将当前点云中的点与地图中的边缘和平面进行匹配。还有许多研究扩展了基于几何特征的匹配算法以实现更好的性能,例如LeGO-LOAM[7]在特征提取之前利用分离地面优化,算法软件系统框图如图 3所示。R-LOAM(reference LOAM)[25]结合参考对象提取的网格特征,有效减少了长期漂移,但对3维网格和参考对象定位精度有较高要求。由于不需要点云转换关系的先验信息,利用了特定形状的几何特征迭代求解,基于几何特征的匹配算法计算量大大减少,实时性较好,匹配精度高,被广泛应用;缺点是当环境中的几何特征不明显时,结果可能会不准确、不稳定。

|

| 图 2 特征扫描匹配 Fig.2 Feature scan matching |

面元(Surfel)是一种基于点的渲染方法,用点云而非多边形网格来渲染3维形状,但是需要GPU处理。DROESCHEL等[26]利用面元特征,将连续的3D激光扫描与增量构建的多分辨率栅格地图配准;为实现测量稀疏和网格离散化情况下的准确性,在高斯混合模型中以概率方式分配面元,提高算法的准确性和效率。参照视觉SLAM中Elastic-Fusion[27]的处理方式,包括SuMa[10],Elastic-LiDAR Fusion[28]将激光雷达点云数据的形状近似为面元,利用面元特征实现激光里程计。SuMa算法的软件系统框图如图 4所示。

3) 基于数学特征的匹配算法

基于数学特征的匹配算法是使用各种数学性质来表征扫描数据和数据帧姿态变化的扫描匹配方法,具有代表性的有基于正态分布变换(normal distributions transform,NDT)的匹配算法,NDT算法是一种快速空间建模技术,用以建立精简的目标3维点云模型。

2003年,BIBER等[29]提出了基于正态分布变换函数的点云配准2D-NDT(2-dimension NDT)算法并成功应用于SLAM中。其在配准的过程中利用正态分布表示关键帧,得到全局姿态的集合。对于大量的点云数据,NDT算法比ICP算法配准速度快,但配准精度不如ICP算法高。2006年,MAGNUSSON等[30]提出了3D-NDT(3-dimension NDT)算法,并不断加以改进[31-32],使之更适用于激光雷达点云数据的配准。ONDT(occupancy NDT)算法[33]研究了多维正态分布变换的地图表示,相较于OctoMap和NDT-OM(normal distributions transform occupancy mapping)等3D地图表示,在内存消耗较低情况下,准确性较高且运行速度快。RGC-NDT(regional growth clustering normal distribution transformation)算法[34]使用聚类算法捕获细节自然特征,相比传统NDT算法,匹配准确度提高1.18倍,且匹配耗时仅为其1/3。2021年,KOIDE等[35]结合NDT和类ICP算法的优势提出了VGICP(voxelized GICP)算法,通过体素化的方法扩展GICP算法,避免了高代价的最近邻搜索,能够快速准确地实现3维激光点云配准。

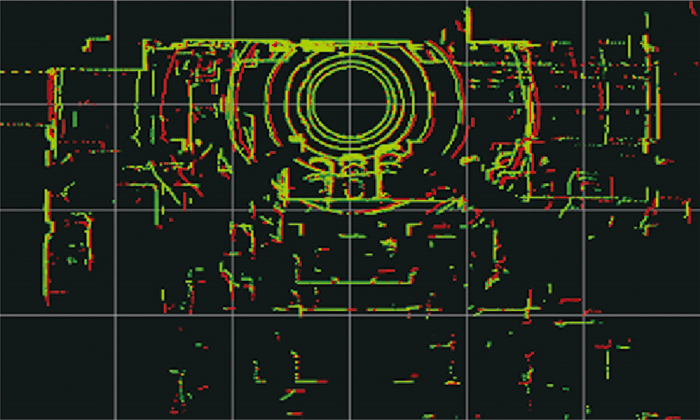

1.2 闭环检测SLAM前端的近似计算和后端的渐近建图都会因传感器的信息偏差而产生计算误差,并且会不断累积。闭环检测则是避免误差过多累积的关键模块,如实际闭环被正确检出,则可大大减少相应两个时刻位姿等信息的估计误差,进而校正全局相关时刻位姿和地图信息的误差;如误判实际相距较远位置所得的两组点云为闭环,则可能导致全局位姿和地图信息的近似计算出现较大偏差,甚至导致约束信息不一致而不可解[36]。更加紧凑、准确的闭环约束最终可以形成拓扑一致的轨迹地图,其准确性和效率对SLAM均很关键,过程如图 5所示。由于3D激光点云数据信息单一、无序且较稀疏,随着点云匹配的时间增长,SLAM往往会出现轨迹不准确、构建地图重叠等问题。但是目前,闭环检测仍然没有广泛认可的最佳解决方案。

|

| 图 5 闭环检测(绿色为当前帧点云,红色为历史回环帧点云) Fig.5 Closed loop detection (The green is the current frame point cloud, and the red is the historical loop-closure frame point cloud) |

OLSON[37-38]通过旋转和平移判断两帧激光数据的相似性,采用相关性扫描匹配的方法达到闭环检测的效果。LeGO-LOAM[7]则利用ICP算法结合欧氏距离进行闭环检测。然而,这类简单的利用几何估计的策略由于前端里程计的累积漂移误差较大,可能导致在大规模环境中无法有效地进行闭环检测。

除两组点云点对点的直接匹配,另一种方法是用几何信息、强度信息或者其他来构造描述符,再通过比较描述符衡量相似度,有基于手工设计和基于深度学习两种方法。前者可以直接处理3维点云,包括基于局部的描述符、基于全局的描述符和基于混合的描述符;后者需要将3维点云表示成深度学习可处理的格式,如预处理为结构化的、固定大小的表示形式。有效提取具有鉴别能力和鲁棒性的特征描述符也是学者关注和研究的问题之一。

局部描述符是从每个关键点位置提取,并基于词袋模型进行场景匹配,提高了匹配能力和鲁棒性。许多关键点检测的方法被提出,如3DSift(3-dimensional sift)[39]、3DHarris(3-dimensional Harris)[40]、3D-SURF[41]、ISSs(intrinsic shape signatures)[42]及局部描述符如SHOT(signature of histogram of orientation)[43]、B-SHOT (binary signature of histogram of orientation)[44]、ISHOT (intensity signature of histogram of orientation)[45]和FPFH(fast point feature histogram)[46]。

局部描述符对激光点云的稀疏和不连续特征鲁棒性不足,忽略了局部特征之间的关系;通常需要大量的局部几何计算,而全局描述符更擅长检测具有高重复性的关键点,在全局点云中进行匹配。M2DP(multiview 2D projection)[47]将点云投影到多个2维平面中,并为每个平面的点生成一个密度签名,这些签名的左右奇异向量被用作全局描述符。基于几何关系的平移和旋转不变的3D描述符,GLAROT-3D(geometric landmark relations rotation-invariant 3D)[48]将关键点对的相对几何位置编码成直方图。Scan Context[49]方法则利用存储高度值的2维矩阵格式的数据作为描述符;还提出了融合相似度评分和最近邻搜索以实现快速的搜索以及采用两阶搜索算法检测回环。

通过集成几何和强度特征,WANG等[50]提出了一种两阶段的分层位置重识别策略ISC(intensity scan context)以提高效率,包括基于二元运算的快速几何检索和强度结构匹配。受启发于人类虹膜,LiDAR Iris[51]将环境的高度信息编码为像素强度并提取一个用以判别的二值特征图像,使用对应图像的汉明距离计算相似度。将点云分割成不同的对象,Seed[52]将分割对象的拓扑信息编码到全局描述符中。这些方法将几何结构编码为描述符并取得了良好的效果,但是目前激光的全局或者局部描述子的描述能力和旋转不变性能仍然有所欠缺,集成更高级的特征可以进一步增强描述符的鉴别能力。

基于混合的描述符如SegMatch(segment matching)[53]和SegMap(segment mapping)[54-55]将一个点云聚为多个段,并提取片段特征,使用KNN(K-nearest neighbour)算法来识别对应物,结合局部描述和全局描述的优势解决了点云数据稀疏、形式单一的问题。SegMap描述符解决了实时单一和多机器人系统的数据压缩要求,也可以用于密集环境的三维地图重建和语义信息提取,用于导航任务和面向机器人操作员等最终用户的视觉反馈。SegGraph(segment graphing)[56]在分割点云后以边匹配为主要依据,基于K-公共子图判定方法实现闭环检测。

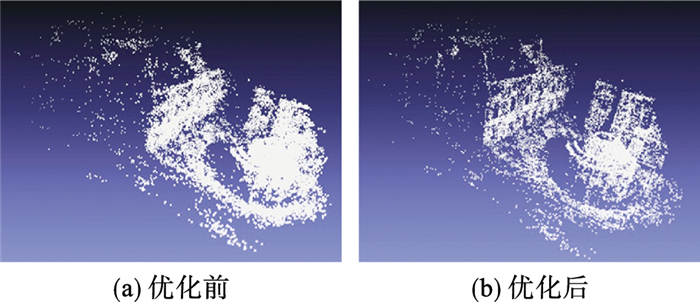

2 SLAM后端3D激光SLAM算法中,后端优化的目的是将各帧雷达的位姿和帧间运动约束综合起来达到整体优化,以消除局部累计误差,并根据前端提供的数据生成环境地图估计,主要有滤波和非线性优化两种思路:滤波主要采用扩展卡尔曼滤波获得最优估计,存在适应性差、缺少回环检测、更新效率慢等问题,难以在回环多、距离长的大规模环境中应用;非线性优化方案以图优化为代表,进行全局优化,把所有数据都考虑进来,虽然会增大计算量,但融合精度较高。后端优化前后对比如图 6所示,如何高效地通过后端优化来修正运动位姿和提高地图精度是SLAM算法的研究热点。

|

| 图 6 后端优化前后对比 Fig.6 Comparison before and after back-end optimisation |

基于滤波理论的SLAM算法主要是利用了贝叶斯估计的原理,具体可分为基于卡尔曼滤波的SLAM算法和基于粒子滤波的SLAM算法[57]。

基于扩展卡尔曼滤波的SLAM算法通过将非线性的运动模型和观测模型线性化处理进而实现SLAM,此过程会引入线性化误差,鲁棒性较差且计算效率低[58]。JULIER等[59]研究了无迹卡尔曼滤波方法,对非线性系统进行无迹变换,其精度比扩展卡尔曼滤波方法高。

粒子滤波方法使用一定数量的、带有权重的粒子来代表状态的后验概率分布,可用于非线性非高斯的系统。MURPHY等[60]提出了RBPF(Rao-Blackwellized particle filter)算法,分别使用扩展卡尔曼滤波算法和粒子滤波算法来解决机器人位置校正和位置估计问题,极大地降低了算法的计算复杂度。Fast-SLAM[61]就是基于RBPF的SLAM算法,它提高了地图精度。GRISETTI等[62]考虑了传感器信息模型并且采用自适应重采样技术来保持合理的粒子种类,并提出了gmapping来改善粒子退化问题,其使用了较以前方法低一个数量级的粒子数量就生成了高精度地图,是激光SLAM的一个里程碑。

2.2 基于非线性优化的SLAM算法图优化算法框架由LU[63]等提出,是目前应用最为广泛的SLAM框架之一。图优化算法框架通过维护关键节点以达到优化的目的,在保证精度的同时大大降低了计算量,如图 7所示。基于图优化的算法可以分为基于最小二乘法的优化、基于松驰技术的优化、基于随机梯度下降法的优化和流形优化四种[64]。KONOLIGE等[65]提出了用于2维姿态图的Karto SLAM开源方案,一定程度上取代了基于滤波理论的SLAM方案,但实时性较差。Cartographer[66]融合多传感器数据创建局部子图,采用子地图匹配算法进行全局优化,能够构建2维和3维点云地图,效率高,鲁棒性好,缺点是计算资源消耗大,在环境较大、计算资源不足时可能出现无法正常回环的现象。

|

| 图 7 图优化算法框架 Fig.7 Framework of graph optimization algorithm |

针对非线性优化问题已存在成熟C + +开源库,如Google开源库Ceres Solver[67],基于图优化的开源优化库有iSAM (incremental smoothing and mapping)[68]、GTSAM(Georgia tech smoothing and mapping)[69]、G2O(general graph optimization)[70]、BA(bundle adjustment)[71]等,借助这些优化库可节省后端迭代求解优化值的时间。

3 基于深度学习的3D激光SLAM算法基于深度学习的方法通过数据驱动的方式学习,能够得到比手工设计更加精确的模型。SLAM与深度学习的结合主要是将深度学习应用到传统SLAM框架的一个或几个环节,如帧间估计、闭环检测等,以提高SLAM算法的效率、精度和鲁棒性,表 1列出了一些实现帧间估计、闭环检测的特征学习算法;或是语义SLAM中利用深度学习提取语义信息、构建语义地图,以提高机器人的自主理解能力。

| 方法 | 分类 | 时间 | 算法 | 特点 |

| 基于特征的学习方法 | 基于体素网格学习 | 2017 2019 |

3DMatch FCGF |

自我监督局部特征 学习方法 1×1×1内核快速 提取特征提高基 于体素描述符 |

| 在点云上学习 | 2018 2019 2020 |

PPF-Net 3DSmoothNet IDAM |

深度网络学习局部 PPF特征 深度网络学习旋转 不变手工特征 深度学习的3D点 云配准网络 |

|

| 端到端学习网络 | 回归 | 2019 | RelativeNet DeepVCP |

3D局部描述符从 特征估计位姿 端到端学习的3D点 云配准网络 |

| 神经网络优化组合 | 2020 | DGR FMR |

基于深度学习的 全局配准框架 弱监督学习的3D 特征描述符 |

后端算法从线性滤波逐步向非线性优化发展,其中因子图优化与滑动窗口结合的方法以其良好的实时性和鲁棒性,被广泛应用在各类融合定位和建图系统中。

3.1 帧间估计与前文中基于几何信息接近策略的扫描匹配算法相比,基于深度学习的帧间估计方法性能卓越。但是由于数据稀疏性和计算成本高,传统的卷积模型无法直接应用到点云中。总的来说,利用深度学习实现帧间估计的方式有两种:1) 基于特征学习的点云配准方法,如GMM(Gaussian mixed model)[72]、3DFeat-Net[73]、FCGF(fully convolutional geometric features)[74]、SiamesePointNet(Siamese point network)[75]、UGMMReg(unified Gaussian mixture model registration)[76];2) 基于端到端的深度网络模型的点云配准方法,如DeepGMR (Deep Gaussian mixture registration)[77]、3DRegNet(3D registration network)[78]、MLP_GCN(multilayer perceptron- graph convolutional networks)[79]、IPCR(iterative point cloud registration)[80]。

现有的许多实验表明,直接应用配准的数学理论会花费巨大的计算时间,而直接应用深度学习无法保证准确性。直接结合深度学习和ICP仍然需要很高的计算时间。将传统的数学理论和深度神经网络融合到端到端的框架中[81],以获得高精度和高效率,是未来的研究方向。

3.2 闭环检测传统的闭环检测大多使用人工选取特征,精确度低、计算量大。相比于传统人工设计的特征,深度学习可以通过大量的学习训练以及合理的网络构建,高效提取对分类无关因素不敏感且区分度高的特征。

近年来,基于深度学习的闭环检测算法逐渐发展。PointNetVLAD(PointNet and NetVLAD)[82]利用PointNet[83]提取局部特征,并利用NetVLAD[84]聚合全局特征,从3维点云端到端提取全局描述符。DH3D(deep hierarchical 3D)[85]从原始的3维点云中学习局部特征,然后使用注意力机制将这些特征聚合为全局特征描述符。KOMOROWSKI[86]提出了一种基于替代点云表示和网络架构的全局点云描述符提取方法——MinkLoc3D。HUI等[87]提出了一种金字塔点云变换器网络PPT-Net(pyramid point cloud transformer network),利用金字塔点Transformer模块来增强对局部特征的区分并生成全局描述符。FastLCD(fast and compact loop closure detection method)[88]直接从原始点云扫描提取多模态特征,编码成全局综合描述符,具有旋转不变性。NDT-Transformer[89]针对大规模点云,通过学习轻量级处理后的NDT单元的全局描述符进行闭环检测。ZHOU等[90]提出了一种基于局部3D深度描述符的闭环检测方法,通过一种新颖的重叠度计算方法检测闭环,实现了更好的精度。Overlap-Transformer[91]是一个轻量级的Transformer神经网络,基于深度图像构造全局描述符进行闭环检测。

由于图像特征描述符(如SIFT(scale invariant feature transform)[92])的惊人性能和高成熟度,基于图像的闭环检测发展迅速,然而对于3维点云数据并没有相同成熟的类似方法提出,难以从点云中提取局部特征描述符,然后将其编码为检索任务的全局描述符。尽管基于深度学习的描述符也有突破结果,但是其严重局限性是需要大量的训练数据,当训练和应用于不同地形或在不同条件下获得的数据时,这些方法并不适用;而且它们通常需要GPU,在保持精度的同时,对轻量级网络结构的探索以及对实时性能的追求是当下的研究热点。

几何特征在恶劣环境下难以保证准确的闭环检测,而语义信息不易受环境因素的影响,是一种长期稳定的特征。基于语义信息的方法能够构建长期稳定的定位系统,实现闭环检测。GOSMatch(graph-of-semantics matching)[93]利用场景中的语义对象来检测闭环,通过编码语义对象之间的空间关系构建全局和局部描述符,进行闭环检测。LI等[94]提出了一种基于3D激光数据的合并语义信息和Scan Context的全局描述符SSC(semantic scan context),并利用3阶段检索方法实现闭环检测。张剑华等[95]提出一种基于点云片段匹配约束的方法提升回环检测的效率。RINet(rotation invariant neural network)[96]设计了结合语义和几何特征的旋转等变全局描述符,提高了描述能力,并且通过一个旋转不变的孪生神经网络来预测描述符对的相似性。

3.3 语义分割及语义地图不同于传统SLAM方法以静态环境假设为前提,语义SLAM可以预知物体的可移动属性;共享相似物体表示,通过维护共享知识库提高了SLAM系统的可扩展性和存储效率;可以应对复杂场景,实现智能路径规划[97]。语义SLAM的关键在于对目标物体的精准识别,而深度学习技术恰好是当前最具潜力和优势的物体识别方法,因此深度学习和语义SLAM的结合受到广泛关注。语义SLAM研究主要是利用语义信息辅助定位及构建语义地图,通过语义特征提取、动态物体剔除以提高SLAM算法的鲁棒性和定位精度;通过高级语义信息为机器人的人机交互提供高层次的语义地图,提高机器人的自主理解能力[98]。

3维点云的语义场景理解在机器人和无人驾驶领域中有着广泛的应用需求,也是目前亟待解决的问题,许多基于3维点云的目标检测和语义分割方法被提出。对于3维点云的几何分类、目标检测和跟踪以及点云分割包括语义分割、实例分割等,GUO等[99]作了较为全面的综述。

由于3维点云的无序性、稀疏性和非结构化特点,为了处理此类非结构化数据,通常将点云转换为3D体素网格或2D投影的结构化形式,或者直接作用于输入点云定义一种新操作。开创性工作PointNet[83]利用尺度变换统一3维点云输入,再通过Max Pooling操作解决点云无序性问题,可直接利用3维卷积神经网络对3维点云进行特征提取和语义分割。基于此,PointNet + +[100]和PointCNN[101]被提出以分层学习深度特征,增强局部模型结构的能力。WANG等[102]提出的图注意力卷积网络GACNet (graph attention convolution network),能够在点云端到端进行结构化特征学习。针对大规模三维点云,HU等[103]提出了高效且轻量级的神经网络架构RandLA-Net(random sampling local feature aggregation network);FAN等[104]提出空间上下文特征学习模块以实现点云语义分割网络架构SCF-Net(spatial contextual feature network)。LAF-Net(local attention fusion network)[105]则是能够自适应融合低维特征和高维语义信息的局部注意力融合模型。在PointNet + +基础上,DSPNet + +(deep scale purifier network + +)[106]是基于自注意力机制的特征提取模块,直接处理原始点云进行端到端的点云分割。

尽管这些基于点的方法直接应用于原始点云,不会丢失任何信息,然而大多数方法需要采用邻近搜索机制,固有地限制了这些方法的效率,且计算量大,无法部署在资源受限的设备上。

基于距离图像,RangeNet + +[107]通过卷积神经网络(convolutional neural network,CNN)实现了语义分割;RangeSeg(range-aware real time segmentation)[108]获得了准确的实例级分割结果。为了更好地处理3维点云并克服点密度不均匀和体素化步骤中信息丢失等限制,(AF)2-S3Net[109]设计了一个端到端的编码器-解码器3D稀疏CNN。FIDNet(fully interpolation decoding network)[110]设计了一种新的基于投影的激光雷达点云语义分割的神经网络。为了利用不同视图的优势,基于多视图融合方法,RPVNet(range-point-voxel fusion network)[111]设计了一种新颖的距离-点-体素融合网络;Hybrid CNN-LSTM(hybrid convolutional neural network and long short-term memory)[112]结合了空间上下文和时间序列信息解决CNN网络池化层丢失细节的缺点,由高效的点云特征处理方法和新颖的神经网络结构组成。LIU等[113]提出了解决弱监督多任务3D点云理解的统一框架WeakLabel3D-Net;基于点云局部几何特征无监督生成聚类,且提出了一种基于学习的聚类级相似性预测网络。

尽管这些方法实现了先进的性能,然而由于将点云转换为结构化形式的量化存在不可避免的几何信息丢失,且处理大规模点云时将导致消耗大量资源。如何设计一个模型能够可靠、快速地实现激光雷达点云的语义分割仍然是一个有待解决的问题。

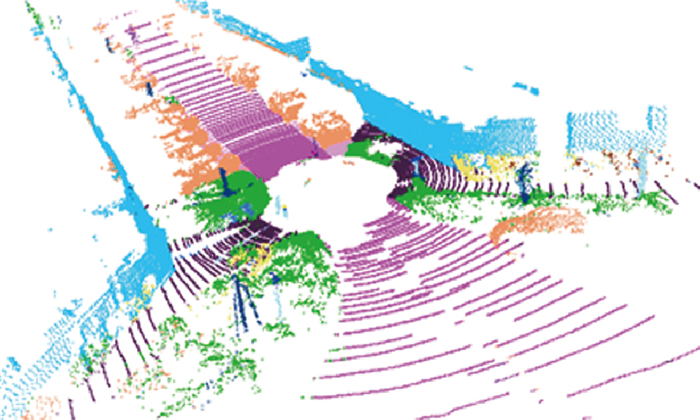

在构建语义地图方面,Recurrent-OctoMap算法[114]是融合语义特征的语义映射方法,使用循环神经网络及单帧语义检测,可以灵活地维护长期的语义地图。SuMa + +[115]是SuMa算法的扩展方法,利用全卷积神经网络有效提取语义信息,并将语义信息集成到基于面元的地图表示上。SA-LOAM(semantic- aided LOAM)[116]是基于LOAM的语义辅助激光SLAM算法,利用里程计和回环检测中的语义信息,提高了定位精度,能有效地进行闭环检测,在大规模场景中可构造全局一致语义地图,其在KITTI序列13的语义分割结果如图 8所示。目前完备的语义辅助激光SLAM系统值得进一步的探索和尝试。

不同传感器获取环境观测信息的处理方式不同,单一传感器都存在着局限性问题,表 2对比了单一传感器优缺点。

| 传感器 | 优点 | 缺点 |

| 激光雷达 | 获得深度信息,可靠性和精度高 | 数据量大且离散,垂直分辨率低,提取特征有限,重定位能力较差 |

| 视觉传感器 | 丰富的环境纹理信息,适用范围广 | 传感器动态性能不稳定,易受光源干扰,鲁棒性低 |

| 惯性测量单元 | 获取准确的角度、位姿信息 | 累计误差较大 |

| 毫米波雷达 | 测试精度高、可靠性强 | 空气中传播损耗较大,只适用于短距离测量 |

单一传感器都无法独立完成所有场景下的全局地图构建,而多传感器的融合能够解决单一传感器的局限性,获得更精确、高效、适应性强的SLAM效果。由于不同模态传感器获取到的数据,格式不同。多模态数据的处理和增强依然是当前基于多传感器融合的3D激光任务的关键。

4.1 激光雷达与惯性测量单元融合激光雷达和惯性测量单元(inertial measurement unit,IMU)的融合可以克服激光SLAM过程中激光雷达垂直分辨率低、更新速率低以及由运动引起的失真等问题[117]。激光雷达与IMU的融合有紧耦合和松耦合两种方式。紧耦合是通过联合优化所有测量数据以在复杂变化的环境中获得准确的位姿估计,但存在计算量大、实时性差等问题。松耦合是分别处理每个传感器的测量数据,再进行融合的方式,计算量小、易于实现,但在定位精度上存在局限性。

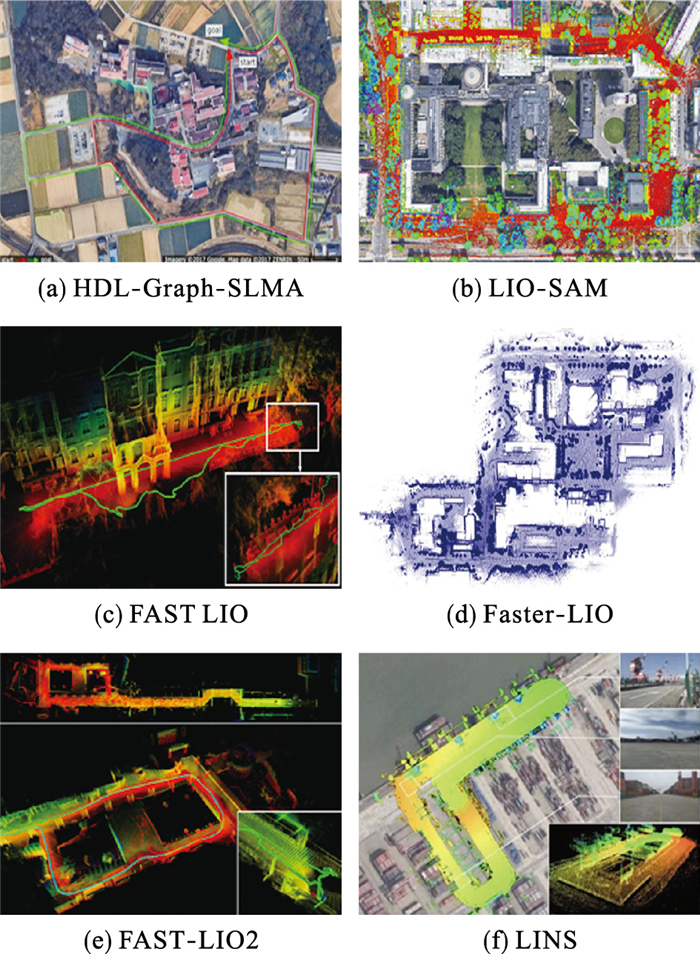

HDL-Graph-SLAM算法[118]融合了多种输入,包括IMU、LiDAR传感器以及GPS(global positioning system)信息,资源消耗小且精度较高。李帅鑫等[119]提出一种LiDAR/IMU紧耦合的实时定位方法Inertial-LOAM,显著降低连续配准误差造成的误差累计,提升了定位精度和实时性。YE等[120]研究了LiDAR-IMU紧耦合的LIO-mapping算法,建图精度提高了,但是紧耦合算法复杂度较高,后期融合其他传感器较困难。ZHAO等[121]研究了紧耦合激光惯性的LIOM (laser-inertial odometry and mapping)算法,实现了低漂移、强鲁棒性的位姿估计。在LeGO-LOAM的基础上,LIO-SAM(LiDAR inertial odometry via smoothing and mapping)[122]应用因子图框架融合了IMU预积分因子、激光里程计因子、GPS因子、闭环检测因子,可以得到更好的精度和实时性、低漂移。LI等[123]则研究了固态激光雷达与IMU的耦合方案,提出了用于实时激光惯性里程计和映射的新型传感器融合方法LiLi-OM(livox LiDAR odometry and mapping)。

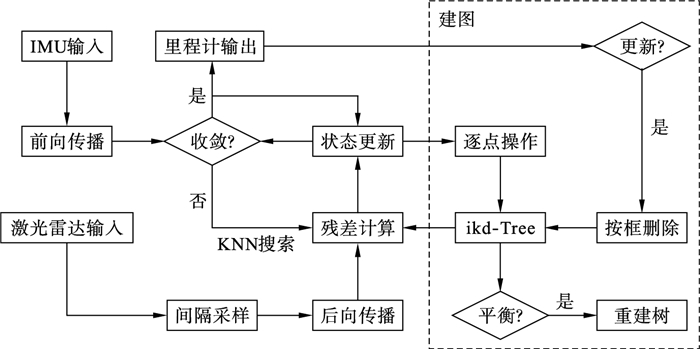

FAST-LIO(fast LiDAR-inertial odometry)[124]紧耦合激光雷达和IMU测量,利用快速卡尔曼增益公式将计算复杂度从测量维度降低到状态维度,计算效率显著提高,但是系统只能在小型环境中工作。FAST-LIO2[125]继承了FAST-LIO紧耦合的融合框架,通过开发的ikd-tree(incremental k-d tree)数据结构,计算量显著减少,提高了里程计和地图绘制的准确性和鲁棒性,算法框图如图 9所示。在FAST-LIO2的基础上,Faster-LIO[126]使用增量体素作为点云空间数据结构,实现了轻量级紧耦合激光雷达惯性里程计,可用于固态激光雷达。LINS(LiDAR-inertial-SLAM)算法[127]不同于采用以世界为中心的固定全局帧的状态估计量的紧耦合方法,而使用机器人中心公式表示移动局部帧的状态估计量,设计了迭代误差状态卡尔曼滤波器实现激光雷达和IMU的紧耦合。该方法在各种具有挑战性的场景中,如无特征场景,也能够实现鲁棒和高效的算法性能,算法框图如图 10所示。图 11为激光惯性耦合SLAM代表性结果。

综上可知,激光惯性紧耦合研究主要通过激光雷达和IMU的紧耦合来提高建图的精度、效率和鲁棒性。但目前针对激光雷达与IMU的联合标定方法还不成熟。

4.2 激光雷达和视觉融合激光SLAM局部定位精度高但全局定位能力差且对环境特征不敏感,而视觉SLAM全局定位能力好但局部定位相对激光雷达较差,两者融合可以提高SLAM系统的精度和鲁棒性。

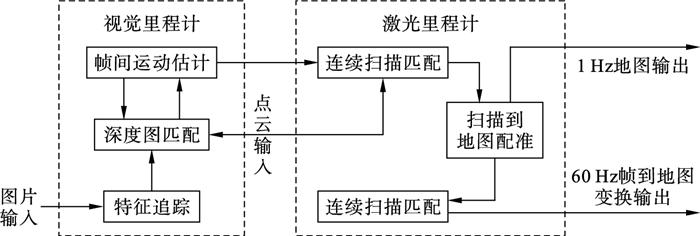

ZHANG等[128]研究了视觉和激光雷达里程计结合的通用框架V-LOAM(visual LOAM),如图 12所示,利用视觉里程计处理快速运动,而激光雷达里程计保证在不良照明条件下的低漂移和稳健性,算法结果低漂移、鲁棒、快速,长期在KITTI数据集的平均平移和旋转误差基准测试上占据榜首,但没有考虑闭环检测和室外长距离环境中位姿轨迹与建图的整体一致性。LVI-SAM(LiDAR-visual-inertial odometry via smoothing and mapping)[129]是紧耦合激光雷达- 视觉- 惯性里程计的SLAM框架,由视觉惯性系统和激光雷达惯性系统组成,能够构建完整且精度高的地图,实时性和精度高,鲁棒性强。Super Odometry[130]是高精度多模态传感器融合框架,采用以IMU为中心的数据处理管道,结合了松耦合和紧耦合方法的优点,在感知退化的环境中也能实现稳健的状态估计。R2LIVE(robust,real-Time,LiDAR-inertial-visual tightly-coupled state estimator and mapping)[131]、R3LIVE(robust,real-time,RGB-colored,LiDAR-inertial- visual tightly-coupled state estimation and mapping)[132]融合激光雷达、IMU和视觉传感器的测量来实现稳健和准确的状态估计,在各种具有挑战性的情况下,甚至在具有大量运动物体和小激光雷达视场的狭窄隧道状环境中,该方法也具有足够的鲁棒性。表 3列出了激光雷达与惯性测量单元、视觉传感器融合的一些算法。

| 年份 | 算法 | 传感器 | 优缺点 |

| 2015 | V-LOAM | 激光雷达、 相机 |

精度高、算法鲁棒性好; 漂移匀速假设、 无闭环检测 |

| 2018 | LIMO | 激光雷达、 相机 |

轨迹误差和旋转 误差较小 |

| 2019 | LIOM | 激光雷达、 IMU |

视觉的滑动窗口应用到激 光帧间匹配,实时性差 |

| LIC-Fusion | 激光雷达、 相机、IMU |

视觉数据和激光数据 没有进行关联 |

|

| 2020 | LIO-SAM | 激光雷达、 IMU |

因子图优化,代码简单; 关键帧之间的特征被丢弃 |

| LINS | 激光雷达、 IMU |

可适应非结构化场景; 计算复杂,耗时长 |

|

| 2021 | LiLi-OM | 固态激光 雷达、IMU |

轻量化,将紧耦合的LIO 方法加载在固态激光雷达 |

| LVI-SAM | 激光雷达、 IMU |

激光里程计和视觉 里程计的紧耦合 |

|

| FAST-LIO2 | 激光雷达、 IMU |

Kdtree搜索,提高效率 | |

| R3LIVE | 激光雷达、 相机、IMU |

可以构建带有颜色信息 的稠密3维地图 |

|

| 2022 | Faster-LIO | 激光雷达、 IMU |

采用体素网格,运行 速度低 |

FRITSCHE等[133-135]将毫米波雷达与激光雷达相结合以应对烟雾、雾或灰尘导致的低能见度恶劣环境,研究了毫米波雷达与激光雷达数据二值决策融合方法和加权融合方法,还探索了两者扫描级和地图级数据融合的可行性。CHAVEZ-GARCIA等[136]研究了基于相机、毫米波雷达和激光雷达的多传感器融合方案,首先利用激光雷达和相机图像信息检测人和车辆,再融合雷达检测信息区分静止目标和移动目标,实现目标的检测与跟踪,减小了误检概率。KIM等[137]提出了一种基于相机、毫米波雷达、激光雷达和GPS的融合方案,首先利用相机和激光雷达构建地图,然后利用GPS确定车辆位置,同时利用雷达检测的目标运动数据更新地图中的环境信息。崔巍杰[138]选取了Google的Cartographer算法框架作为算法的主要框架,综合考虑毫米波雷达与激光雷达的数据优缺点,融合二者的数据实现了环境适应性更高的SLAM算法。

5 3D激光SLAM算法的发展趋势1) 多源信息融合

前已述及,单一传感器均存在着一定局限性,无法满足全场景下的SLAM算法。国内外学者为弥补单一传感器缺陷,研究了多种多传感器融合方案获取高精度和高鲁棒性的地图,有与IMU融合的,有与视觉融合的,也有与其他类型如毫米波雷达融合的;还有多个激光雷达的融合,如M-LOAM(multi-LiDAR LOAM)[139],许多基于各种融合方案的SLAM算法被提出,成果颇多。但相关研究仍是3D激光SLAM算法的研究热点和发展趋势之一,包括对融合层次的探索,鲁棒适应性强且实时在线的多传感器综合校准、时间同步方法的开发,以及通用鲁棒的几何特征提取、数据关联、耦合方法等。同时,基于点云的深度学习方法和基于非线性联合优化的算法将加速多源信息融合技术的发展。

2) 与深度学习的结合

3D激光SLAM算法与深度学习的结合能够提高运行效率和鲁棒性,其研究方向包括特征提取与匹配、语义SLAM、深度估计以及重定位等等仍是研究热点。虽然越来越多的深度学习技术与成果应用于SLAM领域,已经有了许多相关研究工作[73-90, 98-111],但现阶段基于深度学习的SLAM有着明显的局限性,通过深度学习构建的模型缺少直观的物理意义;其次,深度学习技术往往需要大量的训练数据,前期训练周期长;结合深度学习的SLAM通常需要GPU,在计算资源有限的条件下无法应用。

3) 应用场景的鲁棒性

随着机器人技术的迅速发展和应用领域的不断深化,相应的应用场景亦不断丰富和拓展,如空旷、复杂多变的或者动态的场景,也包括地面/空中机器人、汽车/AGV自动驾驶等领域,故越来越多的应用环境细分也有待挖掘。不同应用场景SLAM算法表现不近相同,如针对室内环境,LOAM算法缺乏联合优化,实时姿态估计误差大,π-LSAM(LiDAR smoothing and mapping with planes)[140]改进了LOAM,在后端引入联合优化并显著降低优化算法计算复杂度。

面对一些具有挑战性的复杂多变的应用场景,如变化的光照、剧烈运动、开阔场地或缺乏纹理的场景等,需要开发长期稳健安全的算法,提高算法鲁棒性,许多方面如多机器人系统中全局定位与目标检测、优化轨迹并创建全局一致性地图的方法及动态场景或大场景的环境地图构建方法都需要完善。同时立体匹配、3维场景重建、虚拟现实等计算机前沿应用中,3D激光SLAM算法也可起到关键作用。

4) 探索通用框架和地图表现形式

探索3D激光SLAM框架的通用性也是研究热点,现有3D激光SLAM算法很多沿用了LOAM的框架;IMLS-SLAM算法[9]描述了帧到模型的匹配框架;F-LOAM(fast LiDAR odometry and mapping)[141]提出了一种结合特征提取、失真补偿、姿态优化和映射的通用框架。更好的地图表现形式如语义地图,可以大幅提高机器人的自主理解力,亦可提高3D激光SLAM算法的鲁棒性和精度。

5) 传感器和无线信号体制技术的影响

固态激光雷达性能高且成本极低,具有促进或彻底改变机器人行业的潜力,越来越受到关注。如LIN和ZHANG[142]研究了适用于小视场和不规则采样的固态激光雷达的SLAM算法框架Loam Livox,鲁棒性强且实时运行。随着硬件性能和通信功能不断提高,SLAM技术嵌入式实现、移动设备传感器和无线信号体制技术的参与必然也会影响3D激光SLAM算法的发展。如专用处理器(如HoloLens HPU)和一体化功能模组(如Tango模组)等将会大大降低现有硬件平台的计算能力瓶颈和算法调试门槛。

6 结论SLAM算法是移动机器人构建未知环境地图并获取其位姿信息进而实现自主移动的有效手段,可以辅助机器人执行路径规划、自主探索、导航等任务。随着3D激光雷达向低成本、低功耗和高可靠性的应用的发展,3D激光雷达SLAM算法研究取得了丰富的成果和应用案例。本文从SLAM算法经典框架出发,总结分析了其前端、后端以及深度学习与多传感器融合在激光SLAM中的研究现状,系统阐述现在主流的3D激光SLAM算法原理及其存在的问题和不足,探讨了3D激光SLAM算法的研究热点和发展趋势。

SLAM是多学科组合的算法和系统工程,包括硬件模型构建到系统集成,以及各个环节的多线程执行中的资源分配、数据优化以及建图和定位的准确性都需要平衡和整合;关键模块和硬件匹配的升级、场景或应用的丰富和拓展都会影响3D激光SLAM算法的发展。研究多源信息融合、与深度学习结合、动态以及其他场景的应用与拓展、SLAM算法通用框架、以及SLAM算法的嵌入式实现、移动传感器和无线信号体制的技术参与是3D激光雷达SLAM算法的研究热点和发展趋势。

| [1] |

SMITH R C, CHEESEMAN P. On the representation and estimation of spatial uncertainty[J]. The International Journal of Robotics Research, 1986, 5(4): 56-68. DOI:10.1177/027836498600500404 |

| [2] |

TAKETOMI T, UCHIYAMA H, IKEDA S. Visual SLAM algorithms: A survey from 2010 to 2016[J/OL]. IPSJ Transactions on Computer Vision and Applications, 2017, 9(1)[2022-05-07]. https://link.springer.com/article/10.1186/s41074-017-0027-2. DOI: 10.1186/s41074-017-0027-2.

|

| [3] |

KHAIRUDDIN A R, TALIB M S, HARON H. Review on simultaneous localization and mapping (SLAM)[C]//2015 IEEE International Conference on Control System, Computing And Engineering. Piscataway, USA: IEEE, 2015: 85-90.

|

| [4] |

HUANG L. Review on LiDAR-based SLAM techniques[C]//2021 International Conference on Signal Processing and Machine Learning. Piscataway, USA: IEEE, 2021: 163-168.

|

| [5] |

NAM D. GON-WOO V K. Solid-state LiDAR based-SLAM: A concise review and application[C]//2021 IEEE International Conference on Big Data and Smart Computing. Piscataway, USA: IEEE, 2021: 302-305.

|

| [6] |

ZHANG J, SINGH S. LOAM: Lidar odometry and mapping in real-time[C/OL]//Robotics: Science and Systems X[2022-05-20]. http://www.roboticsproceedings.org/rss10/p07.pdf.

|

| [7] |

SHAN T, ENGLOT B. LeGO-LOAM: Lightweight and ground-optimized lidar odometry and mapping on variable terrain[C]//2018 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2018: 4758-4765.

|

| [8] |

GitHub. GitHub-cgbcgb/A-LOAM-NOTED: Chinese annotated version of A-LOAM[EB/OL]. (2020-05-20)[2022-03-27]. https://github.com/cgbcgb/A-LOAM-NOTED.

|

| [9] |

DESCHAUD J E. IMLS-SLAM: Scan-to-model matching based on 3D data[C]//2018 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2018: 2480-2485.

|

| [10] |

BEHLEY J, STACHNISS C. Efficient surfel-based SLAM using 3D laser range data in urban environments[C/OL]//Robotics: Science and System XIV[2022-04-12]. http://www.roboticsproceedings.org/rss14/p16.pdf.

|

| [11] |

CADENA C, CARLONE L, CARRILLO H, et al. Past, present, and future of simultaneous localization and mapping: Toward the robust-perception age[J]. IEEE Transactions on Robotics, 2016, 32(6): 1309-1332. DOI:10.1109/TRO.2016.2624754 |

| [12] |

刘瑞军, 王向上, 张晨, 等. 基于深度学习的视觉SLAM综述[J]. 系统仿真学报, 2020, 32(7): 1244-1256. LIU R J, WANG X S, ZHANG C, et al. A survey on visual SLAM based on deep learning[J]. Journal of System Simulation, 2020, 32(7): 1244-1256. DOI:10.16182/j.issn1004731x.joss.19-vr0466 |

| [13] |

TAHERI H, XIA Z C. SLAM: Definition and evolution[J]. Engineering Applications of Artificial Intelligence, 2021, 97[2022-04-08]. https://linkinghub.elsevier.com/retrieve/pii/S0952197620303092. DOI: 10.1016/j.engappai.2020.104032.

|

| [14] |

周治国, 曹江微, 邸顺帆. 3D激光雷达SLAM算法综述[J]. 仪器仪表学报, 2021, 42(9): 13-27. ZHOU Z G, CAO J W, DI S F. Overview of 3D LiDAR SLAM algorithms[J]. Chinese Journal of Scientific Instrumentation, 2021, 42(9): 13-27. DOI:10.19650/j.cnki.cjsi.J2107897 |

| [15] |

XU X, ZHANG L, YANG J, et al. A review of multi-sensor fusion SLAM systems based on 3D LiDAR[J]. Remote Sensing, 2022, 14(12): 2835. DOI:10.3390/rs14122835 |

| [16] |

BESL P J, MCKAY H D. A method for registration of 3-D shapes[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 1992, 14(2): 239-256. |

| [17] |

CHEN Y, MEDIONI G. Object modelling by registration of multiple range images[J]. Image and Vision Computing, 1992, 10(3): 145-155. DOI:10.1016/0262-8856(92)90066-C |

| [18] |

LOW K L. Linear least-squares optimization for point-to-plane ICP surface registration[R]. Chapel Hill, USA: University of North Carolina, 2004.

|

| [19] |

WANG H, WANG C, XIE L. Lightweight 3-D localization and mapping for solid-state LiDAR[J]. IEEE Robotics and Automation Letters, 2021, 6(2): 1801-1807. DOI:10.1109/LRA.2021.3060392 |

| [20] |

SEGAL A, HAEHNEL D, THRUN S. Generalized-ICP[C/OL]//Robotics: Science and Systems V. [2022-04-20]. http://www.roboticsproceedings.org/rss05/p21.pdf

|

| [21] |

SERAFIN J, GRISETTI G. NICP: Dense normal based point cloud registration[C]//2015 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2015: 742-749.

|

| [22] |

GitHub. GitHub-erik-nelson/blam[EB/OL]. (2016-8-2)[2022/3/27]. https://github.com/erik-nelson/blam.

|

| [23] |

YOKOZUKA M, KOIDE K, OISHI S, et al. LiTAMIN: Lidar-based tracking and mapping by stabilized ICP for geometry approximation with normal distributions[C]//2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2020: 5143-5150.

|

| [24] |

YOKOZUKA M, KOIDE K, OISHI S, et al. LiTAMIN2: Ultra light LiDAR-based SLAM using geometric approximation applied with KL-divergence[C]//2021 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 11619-11625.

|

| [25] |

OELSCH M, KARIMI M, STEINBACH E. R-LOAM: Improving LiDAR odometry and mapping with point-to-mesh features of a known 3D reference object[J]. IEEE Robotics and Automation Letters, 2021, 6(2): 2068-2075. DOI:10.1109/LRA.2021.3060413 |

| [26] |

DROESCHEL D, STVCKLER J, BEHNKE S. Local multi-resolution representation for 6D motion estimation and mapping with a continuously rotating 3D laser scanner[C]//2014 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2014: 5221-5226.

|

| [27] |

WHELAN T, LEUTENEGGER S, SALAS-MORENO R, et al. ElasticFusion: Dense SLAM without a pose graph[C/OL]//Robotics: Science and Systems XI[2022-03-22]. http://www.roboticsproceedings.org/rss11/p01.pdf.

|

| [28] |

PARK C, MOGHADAM P, KIM S, et al. Elastic LiDAR fusion: Dense map-centric continuous-time SLAM[C]//2018 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2018: 1206-1213.

|

| [29] |

BIBER P, STRAßER W. The normal distributions transform: A new approach to laser scan matching[C]//2003 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2003: 2743-2748.

|

| [30] |

MAGNUSSON M. 3D scan matching for mobile robots with application to mine mapping[D]. Orebro, Sweden: Orebro University, 2006.

|

| [31] |

MAGNUSSON M, LILIENTHAL A, DUCKETT T. Scan registration for autonomous mining vehicles using 3D-NDT[J]. Journal of Field Robotics, 2007, 24(10): 803-827. DOI:10.1002/rob.20204 |

| [32] |

MAGNUSSON M, ANDREASSON H, NUCHTER A, et al. Appearance-based loop detection from 3D laser data using the normal distributions transform[C]//2009 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2009: 23-28.

|

| [33] |

SCHULZ C, HANTEN R, ZELL A. Efficient map representations for multi-dimensional normal distributions transforms[C]//2018 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2018: 2679-2686.

|

| [34] |

赵凯, 朱愿, 王任栋. 基于改进NDT算法的城市场景三维点云配准[J]. 军事交通学院学报, 2019, 21(3): 80-84. ZHAO K, ZHU Y, WANG R D. Urban scene 3D point cloud registration based on improved NDT algorithm[J]. Journal of Military Transportation University, 2019, 21(3): 80-84. DOI:10.16807/j.cnki.12-1372/e.2019.03.019 |

| [35] |

KOIDE K, YOKOZUKA M, OISHI S, et al. Voxelized GICP for fast and accurate 3D point cloud registration[C]//2021 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 11054-11059.

|

| [36] |

BAO X, TAN Y. Improved loop detection method based on ICP and NDT registration algorithm[C]//2021 International Conference on Intelligent Computing, Automation and Applications. Piscataway USA: IEEE, 2021: 145-150.

|

| [37] |

OLSON E B. Real-time correlative scan matching[C]//2009 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2009: 4387-4393.

|

| [38] |

OLSON E. M3RSM: Many-to-many multi-resolution scan matching[C]//2015 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2015: 5815-5821.

|

| [39] |

SCOVANNER P, ALI S, SHAH M. A 3-dimensional sift descriptor and its application to action recognition[C]//15th ACM international conference on Multimedia. New York, USA: ACM, 2007: 357-360.

|

| [40] |

SIPIRAN I, BUSTOS B. A robust 3D interest points detector based on Harris operator[C]//2010 Eurographics Conference on 3D Object Retrieval. New York, USA: ACM, 2010: 7-14.

|

| [41] |

KNOPP J, PRASAD M, WILLEMS G, et al. Hough transform and 3D SURF for robust three dimensional classification[C]//Computer Vision-ECCV 2010. Berlin, Germany: Springer, 2010: 589-602.

|

| [42] |

ZHONG Y. Intrinsic shape signatures: A shape descriptor for 3D object recognition[C]//12th International Conference on Computer Vision Workshops. Piscataway, USA: IEEE, 2009: 689-696.

|

| [43] |

SALTI S, TOMBARI F, STEFANO D L. SHOT: Unique signatures of histograms for surface and texture description[J]. Computer Vision and Image Understanding, 2014, 125: 251-264. DOI:10.1016/j.cviu.2014.04.011 |

| [44] |

PRAKHYA S M, LIU B, LIN W. B-SHOT: A binary feature descriptor for fast and efficient keypoint matching on 3D point clouds[C]//2015 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2015: 1929-1934.

|

| [45] |

GUO J, BORGES P V K, PARK C, et al. Local descriptor for robust place recognition using LiDAR intensity[J]. IEEE Robotics and Automation Letters, 2019, 4(2): 1470-1477. DOI:10.1109/LRA.2019.2893887 |

| [46] |

GUO Y, BENNAMOUN M, SOHEL F, et al. A comprehensive performance evaluation of 3D local feature descriptors[J]. International Journal of Computer Vision, 2016, 116(1): 66-89. DOI:10.1007/s11263-015-0824-y |

| [47] |

HE L, WANG X, ZHANG H. M2DP: A novel 3D point cloud descriptor and its application in loop closure detection[C]//2016 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2016: 231-237.

|

| [48] |

RIZZINI D L. Place recognition of 3D landmarks based on geometric relations[C]//2017 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2017: 648-654.

|

| [49] |

KIM G, KIM A. Scan context: Egocentric spatial descriptor for place recognition within 3D point cloud map[C]//2018 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2018: 4802-4809.

|

| [50] |

WANG H, WANG C, XIE L. Intensity scan context: Coding intensity and geometry relations for loop closure detection[C]//2020 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2020: 2095-2101.

|

| [51] |

WANG Y, SUN Z, XU C Z, et al. LiDAR IRIS for loop-closure detection[C]//2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. IEEE, 2020: 5769-5775.

|

| [52] |

FAN Y, HE Y, TAN U X. Seed: A segmentation-based egocentric 3D point cloud descriptor for loop closure detection[C]//2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2020: 5158-5163.

|

| [53] |

DUBÉ R, DUGAS D, STUMM E, et al. SegMatch: Segment based place recognition in 3D point clouds[C]//2017 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2017: 5266-5272.

|

| [54] |

GitHub. GitHub-ethz-asl/segmap[EB/OL]. (2021-3-18)[2022-4-20]. https://github.com/ethz-asl/segmap.

|

| [55] |

DUBÉ R, GOLLUB M G, SOMMER H, et al. Incremental-segment-based localization in 3-D point clouds[J]. IEEE Robotics and Automation Letters, 2018, 3(3): 1832-1839. DOI:10.1109/LRA.2018.2803213 |

| [56] |

廖瑞杰, 杨绍发, 孟文霞, 等. SegGraph: 室外场景三维点云闭环检测算法[J]. 计算机研究与发展, 2019, 56(2): 338-348. LIAO R J, YANG S F, MENG W X, et al. SegGraph: An algorithm for loop-closure detection in outdoor scenes using 3D point clouds[J]. Journal of Computer Research and Development, 2019, 56(2): 338-348. |

| [57] |

BAILEY T, DURRANT-WHYTE H. Simultaneous localization and mapping (SLAM): Part Ⅱ[J]. IEEE Robotics & Automation Magazine, 2006, 13(3): 108-117. |

| [58] |

ZHANG Y, ZHANG T, HUANG S. Comparison of EKF based SLAM and optimization based SLAM algorithms[C]//13th IEEE Conference on Industrial Electronics and Applications. Piscataway, USA: IEEE, 2018: 1308-1313.

|

| [59] |

JULIER S J, UHLMANN J K. Unscented filtering and nonlinear estimation[J]. Proceedings of the IEEE, 2004, 92(3): 401-422. DOI:10.1109/JPROC.2003.823141 |

| [60] |

MURPHY K, RUSSELL S. Rao-Blackwellised particle filtering for dynamic Bayesian networks[M]//DOUCET A, DE FREITAS N, GORDON N, ed. Sequential Monte Carlo Methods in Practice. Statistics for Engineering and Information Science. Berlin, Germany: Springer, 2001: 499-515.

|

| [61] |

MONTEMERLO M, THRUN S, KOLLER D, et al. FastSLAM: A factored solution to the simultaneous localization and mapping problem[C]//18th National Conference on Artificial Intelligence. Menlo Park, USA: American Association for Artificial Intelligence, 2002: 593-598.

|

| [62] |

GRISETTI G, STACHNISS C, BURGARD W. Improved techniques for grid mapping with Rao-Blackwellized particle filters[J]. IEEE Transactions on Robotics, 2007, 23(1): 34-46. DOI:10.1109/TRO.2006.889486 |

| [63] |

LU F, MILIOS E. Globally consistent range scan alignment for environment mapping[J]. Autonomous Robots, 1997, 4(4): 333-349. DOI:10.1023/A:1008854305733 |

| [64] |

XIA F, SUN K, YU S, Et al. Graph learning: A survey[J]. IEEE Transactions on Artificial Intelligence, 2021, 2(2): 109-127. DOI:10.1109/TAI.2021.3076021 |

| [65] |

KONOLIGE K, GRISETTI G, KVMMERLE R, et al. Efficient sparse pose adjustment for 2D mapping[C]//2010 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2010: 22-29.

|

| [66] |

HESS W, KOHLER D, RAPP H, et al. Real-time loop closure in 2D LIDAR SLAM[C]//2016 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2016: 1271-1278.

|

| [67] |

CERES S. A large scale non-linear optimization library[EB/OL]. (2022-03)[2022-03-27]. http://ceres-solver.org.

|

| [68] |

KAESS M, RANGANATHAN A, DELLAERT F. iSAM: Incremental smoothing and mapping[J]. IEEE Transactions on Robotics, 2008, 24(6): 1365-1378. DOI:10.1109/TRO.2008.2006706 |

| [69] |

FORSTER C, CARLONE L, DELLAERT F, et al. IMU preintegration on manifold for efficient visual-inertial maximum-a-posteriori estimation[C/OL]//Robotics: Science and Systems XI[2022-12-28]. http://www.roboticsproceedings.org/rss11/p06.pdf.

|

| [70] |

KVMMERLE R, GRISETTI G, STRASDAT H, et al. G2o: A general framework for graph optimization[C]//2011 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2011: 3607-3613.

|

| [71] |

TRIGGS B, MCLAUCHLAN P F, HARTLEY R I, et al. Bundle adjustment - A modern synthesis[C]//1999 International Workshop on Vision Algorithms. Berlin, Germany: Springer, 1999: 298-372.

|

| [72] |

阮晓钢, 张晶晶, 朱晓庆, 等. 基于高斯混合模型最大期望聚类的同时定位与地图构建数据关联[J]. 控制理论与应用, 2020, 37(2): 265-274. RUAN X G, ZHANG J J, ZHU X Q, et al. Simultaneous localization and mapping data association based on maximum expectation clustering for Gaussian mixture model[J]. Control Theory and Applications, 2020, 37(2): 265-274. |

| [73] |

YEW Z J, LEE G H. 3DFeat-Net: Weakly supervised local 3D features for point cloud registration[C]//2018 European Conference on Computer Vision. Berlin, Germay: Springer, 2018: 607-623.

|

| [74] |

CHOY C, PARK J, KOLTUN V. Fully convolutional geometric features[C]//2019 IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2019: 8957-8965.

|

| [75] |

ZHOU J, WANG M J, MAO W D, et al. SiamesePointNet: A Siamese point network architecture for learning 3D shape descriptor[J]. Computer Graphics Forum, 2020, 39(1): 309-321. DOI:10.1111/cgf.13804 |

| [76] |

HUANG X, LI S, ZUO Y, et al. Unsupervised point cloud registration by learning unified Gaussian mixture models[J]. IEEE Robotics and Automation Letters, 2022, 7(3): 7028-7035. DOI:10.1109/LRA.2022.3180443 |

| [77] |

YUAN W, ECKART B, KIM K, et al. DeepGMR: Learning latent Gaussian mixture models for registration[C]//16th European Conference on Computer Vision. Berlin, Germay: Springer, 2020: 733-750.

|

| [78] |

PAIS G D, RAMALINGAM S, GOVINDU V M, et al. 3DRegNet: A deep neural network for 3D point registration[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2020: 7191-7201.

|

| [79] |

SUN L, ZHANG Z, ZHONG R, et al. A weakly supervised graph deep learning framework for point cloud registration[J/OL]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60[2022-03-14]. https://ieeexplore.ieee.org/document/9690169/. DOI: 10.1109/TGRS.2022.3145474.

|

| [80] |

CHEN J, SU Z, ZHAO X. IPCR: An end-to-end iterative point cloud registration network[C]//7th International Conference on Intelligent Computing and Signal Processing. Piscataway, USA: IEEE, 2022: 894-899.

|

| [81] |

XIE D, ZHU W, RONG F, et al. Registration of point clouds: A survey[C]//2021 International Conference on Networking Systems of AI. Piscataway, USA: IEEE, 2021: 136-142.

|

| [82] |

UY M A, LEE G H. PointNetVLAD: Deep point cloud based retrieval for large-scale place recognition[C]//2018 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2018: 4470-4479.

|

| [83] |

QI C R, SU H, MO K, et al. PointNet: Deep learning on point sets for 3D classification and segmentation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2017: 652-660.

|

| [84] |

ARANDJELOVIC R, GRONAT P, TORⅡ A, et al. NetVLAD: CNN architecture for weakly supervised place recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2016: 5297-5307.

|

| [85] |

DU J, WANG R, CREMERS D. DH3D: Deep hierarchical 3D descriptors for robust large-scale 6DoF relocalization[C]//2020 16th European Conference on Computer Vision. Berlin, Germany: Springer, 2020: 744-762.

|

| [86] |

KOMOROWSKI J. MinkLoc3D: Point cloud based large-scale place recognition[C]//2021 IEEE/CVF Winter Conference on Applications of Computer Vision. Piscataway, USA: IEEE, 2021: 1790-1799.

|

| [87] |

HUI L, YANG H, CHENG M, et al. Pyramid point cloud transformer for large-scale place recognition[C]//2021 IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2021: 6098-6107.

|

| [88] |

XIANG H, SHI W, FAN W, et al. FastLCD: A fast and compact loop closure detection approach using 3D point cloud for indoor mobile mapping[J/OL]. International Journal of Applied Earth Observation and Geoinformation, 2021, 102[2022-05-10]. https://www.sciencedirect.com/science/article/pii/S0303243421001379. DOI: 10.1016/j.jag.2021.102430.

|

| [89] |

ZHOU Z, ZHAO C, ADOLFSSON D, et al. NDT-Transformer: Large-scale 3D point cloud localisation using the normal distribution transform representation[C]//2021 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 5654-5660.

|

| [90] |

ZHOU Y, WANG Y, POIESI F, et al. Loop closure detection using local 3D deep descriptors[J]. IEEE Robotics and Automation Letters, 2022, 7(3): 6335-6342. DOI:10.1109/LRA.2022.3156940 |

| [91] |

MA J, ZHANG J, XU J, et al. OverlapTransformer: An efficient and yaw-angle-invariant transformer network for LiDAR-based place recognition[J]. IEEE Robotics and Automation Letters, 2022, 7(3): 6958-6965. DOI:10.1109/LRA.2022.3178797 |

| [92] |

LOWE D G. Object recognition from local scale-invariant features[C]//7th IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 1999: 1150-1157.

|

| [93] |

ZHU Y, MA Y, CHEN L, et al. GOSMatch: Graph-of-semantics matching for detecting loop closures in 3D LiDAR data[C]//2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2020: 5151-5157.

|

| [94] |

LI Y, SU P, CAO M, et al. Semantic Scan Context: Global semantic descriptor for LiDAR-based place recognition[C]//2021 IEEE International Conference on Real-time Computing and Robotics. Piscataway, USA: IEEE, 2021: 251-256.

|

| [95] |

张剑华, 吴佳鑫, 冯宇婷, 等. 点云片段匹配约束和轨迹漂移优化的回环检测方法[J]. 控制理论与应用, 2018, 35(12): 1750-1758. ZHANG J H, WU J X, FENG Y T, et al. Segment based loop detection with point cloud matching constraint and trajectory drift optimization[J]. Control Theory and Applications, 2018, 35(12): 1750-1758. |

| [96] |

LI L, KONG X, ZHAO X, et al. RINet: Efficient 3D LiDAR-based place recognition using rotation invariant neural network[J]. IEEE Robotics and Automation Letters, 2022, 7(2): 4321-4328. DOI:10.1109/LRA.2022.3150499 |

| [97] |

SALAS-MORENO R F. Dense semantic SLAM[D]. London, UK: Imperial College, 2014.

|

| [98] |

高翔, 张涛, 刘毅, 等. 视觉SLAM 14讲: 从理论到实践[M]. 2版. 北京: 电子工业出版社, 2019. GAO X, ZHANG T, LIU Y, et al. 14 lectures on visual SLAM: From theory to practice[M]. 2nd. Beijing: Publishing House of Electronics Industry, 2019. |

| [99] |

GUO Y, WANG H, HU Q, et al. Deep learning for 3D point clouds: A survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 43(12): 4338-4364. |

| [100] |

QI C R, YI L, SU H, et al. PointNet+ +: Deep hierarchical feature learning on point sets in a metric space[C]//Advances in Neural Information Processing Systems. Red Hook, USA: Curran Associates, 2018: 5100-5109.

|

| [101] |

LI Y, BU R, SUN M, et al. PointCNN: Convolution on x-transformed points[C]//Advances in Neural Information Processing Systems. Red Hook, USA: Curran Associates, 2018: 828-838.

|

| [102] |

WANG L, HUANG Y, HOU Y, et al. Graph attention convolution for point cloud semantic segmentation[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2019: 10296-10305.

|

| [103] |

HU Q, YANG B, XIE L, et al. RandLA-Net: Efficient semantic segmentation of large-scale point clouds[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2020: 11108-11117.

|

| [104] |

FAN S, DONG Q, ZHU F, et al. SCF-Net: Learning spatial contextual features for large-scale point cloud segmentation[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE 2021: 14504-14513.

|

| [105] |

DU S, FAN H, TANG Y, et al. LAF-Net: Local attention fusion for point cloud semantic segmentation[C]//2021 China Automation Congress. Piscataway, USA: IEEE, 2021: 6356-6360.

|

| [106] |

YU L, YU H, YANG S. A deep neural network using double self-attention mechanism for ALS point cloud segmentation[J]. IEEE Access, 2022, 10: 29878-29889. DOI:10.1109/ACCESS.2022.3158438 |

| [107] |

MILIOTO A, VIZZO I, BEHLEY J, et al. RangeNet + +: Fast and accurate lidar semantic segmentation[C]//2019 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2019: 4213-4220.

|

| [108] |

CHEN T H, CHANG T S. RangeSeg: Range-aware real time segmentation of 3D LiDAR point clouds[J]. IEEE Transactions on Intelligent Vehicles, 2021, 7(1): 93-101. |

| [109] |

CHENG R, RAZANI R, TAGHAVI E, et al. (AF)2-S3Net: Attentive feature fusion with adaptive feature selection for sparse semantic segmentation network[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 12542-12551.

|

| [110] |

ZHAO Y, BAI L, HUANG X. FIDNet: LiDAR point cloud semantic segmentation with fully interpolation decoding[C]//2021 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2021: 4453-4458.

|

| [111] |

XU J, ZHANG R, DOU J, et al. RPVNet: A deep and efficient range-point-voxel fusion network for LiDAR point cloud segmentation[C]//2021 IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2021: 16024-16033.

|

| [112] |

WEN S, WANG T, TAO S. Hybrid CNN-LSTM architecture for LiDAR point clouds semantic segmentation[J]. IEEE Robotics and Automation Letters, 2022, 7(3): 5811-5818. DOI:10.1109/LRA.2022.3153899 |

| [113] |

LIU K, ZHAO Y, GAO Z, et al. WeakLabel3D-Net: A complete framework for real-scene LiDAR point clouds weakly supervised multi-tasks understanding[C]//2022 International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2022: 5108-5115.

|

| [114] |

SUN L, YAN Z, ZAGANIDIS A, et al. Recurrent-OctoMap: Learning state-based map refinement for long-term semantic mapping with 3D-LiDAR data[J]. IEEE Robotics and Automation Letters, 2018, 3(4): 3749-3756. DOI:10.1109/LRA.2018.2856268 |

| [115] |

CHEN X, MILIOTO A, PALAZZOLO E, et al. SuMa+ +: Efficient LiDAR-based semantic SLAM[C]//2019 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2019: 4530-4537.

|

| [116] |

LI L, KONG X, ZHAO X, et al. SA-LOAM: Semantic-aided LiDAR SLAM with loop closure[C]//2021 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 7627-7634.

|

| [117] |

XU Y, OU Y, XU T. SLAM of robot based on the fusion of vision and LiDAR[C]//2018 IEEE International Conference on Cyborg and Bionic Systems. Piscataway, USA: IEEE, 2018: 121-126.

|

| [118] |

KOIDE K, MIURA J, MENEGATTI E. A portable three-dimensional LIDAR-based system for long-term and wide-area people behavior measurement[J/OL]. International Journal of Advanced Robotic Systems, 2019, 16(2)[2022-05-27]. https://doi.org/10.1177/1729881419841.

|

| [119] |

李帅鑫, 李广云, 王力, 等. LiDAR/IMU紧耦合的实时定位方法[J]. 自动化学报, 2021, 47(6): 1377-1389. LI S X, LI G Y, WANG L, et al. LiDAR/IMU tightly coupled real-time localization method[J]. Acta Automatica Sinica, 2021, 47(6): 1377-1389. |

| [120] |

YE H, CHEN Y, LIU M. Tightly coupled 3D LiDAR inertial odometry and mapping[C]//2019 International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2019: 3144-3150.

|

| [121] |

ZHAO S, FANG Z, LI H L, et al. A robust laser-inertial odometry and mapping method for large-scale highway environments[C]//2019 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2019: 1285-1292.

|

| [122] |

SHAN T, ENGLOT B, MEYERS D, et al. LIO-SAM: Tightly-coupled LiDAR inertial odometry via smoothing and mapping[C]//2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2020: 5135-5142.

|

| [123] |

LI K, LI M, HANEBECK U D. Towards high-performance solid-state-LiDAR-inertial odometry and mapping[J]. IEEE Robotics and Automation Letters, 2021, 6(3): 5167-5174. DOI:10.1109/LRA.2021.3070251 |

| [124] |

XU W, ZHANG F. FAST-LIO: A fast, robust LiDAR-inertial odometry package by tightly-coupled iterated Kalman filter[J]. IEEE Robotics and Automation Letters, 2021, 6(2): 3317-3324. DOI:10.1109/LRA.2021.3064227 |

| [125] |

XU W, CAI Y, HE D, et al. FAST-LIO2: Fast direct LiDAR-inertial odometry[J]. IEEE Transactions on Robotics, 2022, 38(4): 2053-2073. DOI:10.1109/TRO.2022.3141876 |

| [126] |

BAI C, XIAO T, CHEN Y, et al. Faster-LIO: Lightweight tightly coupled LiDAR-inertial odometry using parallel sparse incremental voxels[J]. IEEE Robotics and Automation Letters, 2022, 7(2): 4861-4868. DOI:10.1109/LRA.2022.3152830 |

| [127] |

QIN C, YE H, PRANATA C E, et al. LINS: A LiDAR-inertial state estimator for robust and efficient navigation[C]//2020 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2020: 8899-8906.

|

| [128] |

ZHANG J, SINGH S. Visual-LiDAR odometry and mapping: Low-drift, robust, and fast[C]//2015 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2015: 2174-2181.

|

| [129] |

SHAN T, ENGLOT B, RATTI C, et al. LVI-SAM: Tightly-coupled LiDAR-visual-inertial odometry via smoothing and mapping[C]//2021 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 5692-5698.

|

| [130] |

ZHAO S, ZHANG H, WANG P, et al. Super dometry: IMU-centric LiDAR-visual-inertial estimator for challenging environments[C]//2021 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2021: 8729-8736.

|

| [131] |

LIN J, ZHENG C, XU W, et al. R2LIVE: A robust, real-time, LiDAR-inertial-visual tightly-coupled state estimator and mapping[J]. IEEE Robotics and Automation Letters, 2021, 6(4): 7469-7476. DOI:10.1109/LRA.2021.3095515 |

| [132] |

LIN J, ZHANG F. R3LIVE: A Robust, Real-time, RGB-colored, LiDAR-Inertial-Visual tightly-coupled state Estimation and mapping package[C]//2022 International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2022: 10672-10678.

|

| [133] |

FRITSCHE P, KUEPPERS S, BRIESE G, et al. Radar and LiDAR sensorfusion in low visibility environments[C]//13th International Conference on Informatics in Control, Automation and Robotics. New York, USA: ACM, 2016: 30-36.

|

| [134] |

FRITSCHE P, WAGNER B. Modeling structure and aerosol concentration with fused radar and LiDAR data in environments with changing visibility[C]//2017 IEEE/RSJ International Conference on Intelligent Robots and System. Piscataway, USA: IEEE, 2017: 2685-2690.

|

| [135] |

FRITSCHE P, KUEPPERS S, BRIESE G, et al. Fusing LiDAR and radar data to perform SLAM in harsh environments[M]. Berlin, Germany: Springer, 2018: 175-189.

|

| [136] |

CHAVEZ-GARCIA R O, AYCARD O. Multiple sensor fusion and classification for moving object detection and tracking[J]. IEEE Transactions on Intelligent Transportation Systems, 2015, 17(2): 525-534. |

| [137] |

KIM B, KIM D, PARK S, et al. Automated complex urban driving based on enhanced environment representation with GPS/map, radar, LiDAR and vision[J]. IFAC-PapersOnLine, 2016, 49(11): 190-195. DOI:10.1016/j.ifacol.2016.08.029 |

| [138] |

崔巍杰. 毫米波和激光雷达数据融合的SLAM算法研究[D]. 成都: 电子科技大学, 2019. CUI W J. SLAM algorithm based on millimeter wave radar and LiDAR data fusion[D]. Chengdu: University of Electronic Science and technology, 2019. |

| [139] |

JIAO J, YE H, ZHU Y, et al. Robust odometry and mapping for multi-LiDAR systems with online extrinsic calibration[J]. IEEE Transactions on Robotics, 2021, 38(1): 351-371. |

| [140] |

ZHOU L, WANG S, KAESS M. π-LSAM: LiDAR smoothing and mapping with planes[C]//2021 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2021: 5751-5757.

|

| [141] |

WANG H, WANG C, CHEN C L, et al. F-LOAM: Fast LiDAR odometry and mapping[C]//2021 IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2021: 4390-4396.

|

| [142] |

LIN J, ZHANG F. LOAM Livox: A fast, robust, high-precision LiDAR odometry and mapping package for LiDARs of small FoV[C]//2020 IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2020: 3126-3131.

|