2. 广州视源电子科技股份有限公司, 广东 广州 510300

2. Guangzhou Shiyuan Electronic Technology Company Limited, Guangzhou 510300, China

0 引言

下肢可穿戴式外骨骼机器人是一种将机器人的力量和人类的智能相结合的人机耦合产品。广泛应用于军事、工业、救援和医疗等诸多领域,可以起到减缓工作人员体力消耗、提高工作效率及降低职业损伤等作用[1-2],近年国内外对该类外骨骼机器人的研究与开发越来越多。

根据实现的功能不同,一般可以分为辅助肢体损伤或肌力较弱人群使用的医疗外骨骼机器人、用于体能增强型外骨骼机器人两类。前者由于用于肢体伤残者,因此对感知系统的实时性与控制器的快速响应性要求不高,因此国内外有很多此类产品推向市场。例如,MindWalker[3]、LOKOMAT(瑞士Hocoma公司下肢康复外骨骼)[4-5]、HAL[6](日本Cyberdyne公司外骨骼)和ReWalk(以色列ReWalk机器人公司康复外骨骼)[7]等下肢外骨骼机器人在帮助下肢患者重新获得运动能力方面取得了不错的成果。而体能增强型外骨骼机器人面向正常人使用,对于外骨骼机器人系统的助力控制,需要使其适应正常人运动的随意性和运动过程中各种突变状况,因此其研究更具有挑战性。目前国内外该类外骨骼机器人的产业化应用比较少。国外具有代表性的是加州大学伯克利分校推出的BLEEX[1, 8-10]助力外骨骼机器人和后续推出的升级版本HULC,以及美国雷神公司研发的XOS系列外骨骼机器人。与国外相比,国内对于体能增强型外骨骼机器人的研究起步晚,技术不成熟且多处于原理技术样机的探索阶段。中科院合肥智能研究所[11]和浙江大学是国内较早从事该项研究的机构[12]。在产业化应用方面,近年国内也有该类外骨骼机器人公司的成立,如上海的傲鲨智能科技有限公司等。本文主要侧重于该类体能增强型外骨骼机器人产业化应用相关技术研究。

作为一种人在控制环中的人机耦合穿戴设备,人机柔顺协调运动控制和适时地进行助力控制是产品化中必须要解决的两个难题,它们直接影响到了外骨骼机器人产品的人机体验舒适性和安全性。为了解决这两个难题,必须实时准确地辨识与预测人体的运动意图。本文主要针对人体运动意图实时辨识中存在的如下问题进行研究探索:如何合理地进行传感器配置和算法框架的选择,使得系统在数据处理量、传输量和运算响应实时性达到平衡。

本文针对以上问题进行了研究。首先,选择日常生活常见的8种运动模式进行了识别。在该部分研究中,通过不同的传感器信息源、特征量和模式识别算法进行测试比较,最后通过在算法执行的准确性、实时性及嵌入式平台的可移植性方面综合比较后得出最优的一组算法参数和最优的传感器配置方案。其次,利用神经-模糊推理系统方法完成对运动相位的实时预测。结果显示,预测的平均延时为61.5 ms,可以达到实时控制的要求。

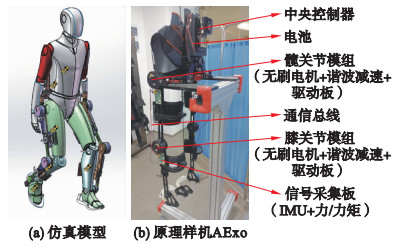

1 系统架构图 1给出了人机仿真模型及原理样机AExo (Assistancc Exoskeleton),用于前期的结构仿真分析和实机性能测试。其中,图 1(a)为在SOLIDWORKS环境中搭建的用于对LL-PAE进行运动学和动力学仿真分析的人机耦合仿真模型;图 1(b)展示了本研究中搭建的原理样机LL-PAE(lower limb power augmentation exoskeleton)。该外骨骼机器人基于人体仿生学设计,各个关节与人体关节轴心平行,方便进行关节运动范围的安全限位。大小腿和腰宽设计为可调,可兼容1.55 m~1.85 m的穿戴者。LL-PAE配备有刚性执行器,可提供髋、膝关节在矢状面内屈曲和伸展运动力矩。此外,被动关节可以实现患者髋关节的外展和内收运动及踝关节的屈曲/伸展运动。在材料使用上,为了实现整机的轻量化和高刚度设计,主要采用航空铝合金和碳纤维主体材料。

|

| 图 1 人机仿真模型及原理样机 Fig.1 Human-machine simulation model and prototype |

三相无刷直流电机用于实现髋关节和膝关节的屈伸运动。为了安全起见,在结构设计中对关节运动进行了物理限制。在软件中也对位置、速度、加速度等一些运动控制参数进行了软限制。为了支持控制算法并实现高速实时控制,开发了一块专用的主控电路板。它带有一个4核CPU处理器(ARM-cortex-A72架构),运行RT-Linux操作系统。CAN总线用于实现节点间的报文通信,由两条通信线组成。其通信速率设置为1 Mb/s,主控制器更新频率为250 Hz。电子设备和电池嵌入在总重量为2.3 kg的背包中。自制信号采集鞋嵌入多个压力传感器,用于检测LL-PAE地面反作用力的轨迹。

中央控制器和电池包布置在背包内,各关节控制器与电机集成在一起布置在靠近各个主动关节处。系统采用24 V、200 W · h电池进行供电,并且被嵌入到了一个快拆的电池背包中以实现其快速更换。本系统通过SD卡扩展8 GB存储空间用于操作系统、驱动程序、应用程序和一些数据的存储。主控制器通过CAN通信网络实现与4个主动动力单元节点控制器、多个传感器信号采集板互联进行数据交互。中央控制器中运行上位两层的控制算法。根据不同的控制策略,中央控制器可以将各个关节模组的运动模式在运动(位置、速度)、力矩及阻抗控制多种模式之间自由切换。

1.1 软件架构参照人体信息感知、决策与运动控制的结构,为LL-PAE搭建了分层控制系统。从上向下依次是上位决策层、中间控制与信号转换层、下位控制与驱动层组成。整个控制系统的作用是在保证外骨骼机器人与穿戴者协调柔顺运动的同时,在适当时刻给穿戴者提供适当助力。

上位决策层为整个控制系统的核心,主要完成人体运动意图的辨识、基于有限状态机(FSM)的状态切换和在线关节轨迹规划等任务。FSM从一个状态到另一个状态的切换需要穿戴者运动意图作为触发条件。而且,为了要实现外骨骼机器人的柔顺控制和实现适时地进行助力控制,穿戴者的运动意图也必须被准确地识别。同时,运动意图识别的实时性,也直接影响系统的鲁棒性,安全性及穿戴的舒适性。所以,本研究的主要工作是针对这一层算法框架及参数优化选择进行开展。

中间控制与信号转换层主要功能为根据识别出的各个运动状态调用对应的动力学模型,实时在线地生成各个关节电机的指令曲线。这些轨迹曲线作为下位控制层的输入,通过各个关节模组内部集成的旋转矢量控制(FOC)算法实现外骨骼机器人关节的运动控制。本系统中的FOC控制算法采用位置、速度和力矩三环控制结构,而且为了方便实现多种运动模式的切换,本系统可以通过预设的开关指令在多种运动模式间自由切换。

1.2 运动意图识别本研究基于多传感器信息融合技术,直接从传感数据中去挖掘学习运动规律,从而快速准确地进行意图识别。

本文将运动意图识别划分为:1) 运动模式的识别;2) 运动相位的识别;3) 运动状态切换事件的预测。其中,1)、2) 是根据训练学习到的知识对当前的情况进行判断,3) 是对即将发生的动作意图进行预测。本研究以日常生活经常涉及到的8个基本动作作为所要辨识的运动模式,即静坐(sit,SI)、站立(stand,SD)、步行(walk,WK)、跑步(run,RN)、上楼梯(stair ascent,SA)、下楼梯(stair descent,SD)、上斜坡(ramp ascent,RA)和下斜坡(ramp descent,RD)。运动相位是各个运动模式下的进一步动作细分。根据不同的研究目的,相位的细分程度是不一样的。例如,人体行走步态粗略地划分可以看作是由交替的站立相和摆动相组成[14],也可以划分为如本文采用的4细分步态相位。

1.3 感知子系统方案人体运动意图不可以通过现有的技术直接获得,而是需要通过对传感器数据的分析,综合来判别与预测。现在常用如下两种信号作为运动意图识别的信息源:1) 使用布置在特定位置的多个摄像头捕捉到的人体的运动图像;2) 使用实时采集的可穿戴于人体的传感器数据。前者主要用于室内场合,但是助力下肢外骨骼机器人设备更多是在户外使用,因此本研究只能选用第二种方案。而对于便携穿戴式传感器的选择,一般也有物理式信号检测如加速度[13-16]、力[17]、角度等测量的传感器和生物电信号检测如肌电信号、脑电信号检测的传感器[18-19]。由于生物电信号检测传感器信号的不稳定性和穿戴不方便等缺点,本技术方案主要采用物理传感器来实现人体运动意图的识别。

对于运动模式的判别,通常采用惯性测量单元(inertial measurement unit,IMU)[15-16, 20]。但是,如文[15-16, 20]所示,具体IMU的检测位置对于不同的研究者采用不同的配置方案。对于步态相位状态的识别,根据文[21-24]可知,足部压力鞋垫或脚踏开关一般被认为是最佳检测选项,因为每个步态阶段都可能与特定的压力模式相关。然而,为了可及时且准确地检测出对应步态相位,力传感器在脚底的布置位置需要有经验的专业人员或根据实验来确定[20]。本研究采用多传感器信息的融合来完成运动意图的识别与预测。为了考虑信号处理的实时性,降低整个系统的复杂性以提高系统鲁棒性,会首先对传感器的配置方案进行研究以实现采用尽可能少的传感器实现高的动作识别精度。

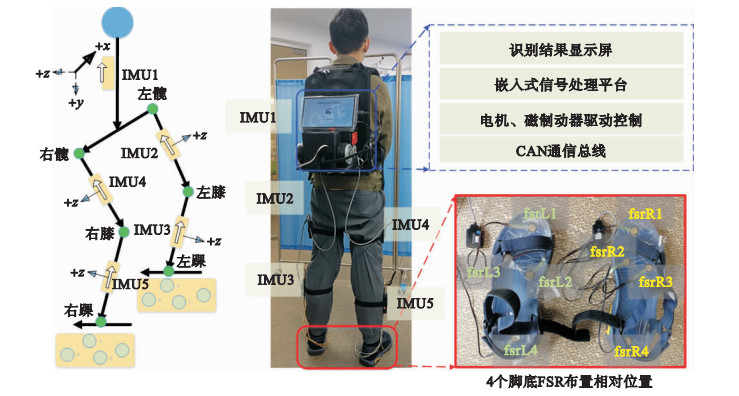

本研究搭建了如图 2所示的传感器冗余配置的实验平台。该实验平台主要完成2个研究内容:一是确定优化的传感器配置方案;二是确定意图识别算法框架和优化参数。

|

| 图 2 算法验证平台传感器布置图 Fig.2 Sensor layout of algorithm validation platform |

图 2系统由中央控制器、传感器系统和通信系统组成。左图表示传感器布置方案及其正方向。本方案采用脚底薄膜压力(force sensitive resistors,FSR) 传感器来识别脚与地面的接触关系。它是应变式压力传感器,有效测量面积为500 mm2,测量量程为0~30 kg,输出量程为0~3.3 V的电压信号。FSR压力传感器分布在脚底的位置为:左右脚后跟各布置1个,分别是fsrL4、fsrR4;左右脚前掌各布置1个,分别是fsrL1、fsrR1;左右脚中部靠内测各布置1个,分别是fsrL2、fsrR2;外侧各布置1个,分别是fsrL3、fsrR3。后背、左右大腿、左右小腿外侧用于检测肢体运动姿态的惯性测量的IMU模块。IMU芯片选用MPU6050,且采用IIC(inter-integrated circuit)接口与信号采集板MCU(microcontroller unit)通信,最后通过CAN传送到中央控制器。同时为了方便查看意图识别输出结果,设置了屏和UI人机界面。

2 实验 2.1 数据采集本节介绍步态数据库的构建。构建的数据库可用于人体运动意图识别模型训练。按照图 3所示给受试者佩戴好传感器,在保证所有的传感器可以正常使用的情况下,受试人员按照图 3所示的8种运动模式进行实验并记录数据。对于周期运动模式至少记录25组完整周期数据,而对于非周期运动,至少记录60 s数据。实验中有一人发号指令,而且每次实验都在指令下从受试者双腿站立开始,结束于双腿站立。各个运动模式的执行都以受试者舒服的方式进行,且允许受试者在各个实验之间休息,以免疲劳。对于步行,分别采集慢走、正常步速和快走条件下的数据。对于上下楼梯和斜坡的数据采集,借助实验室内器材辅助完成。楼梯有5个台阶,每一个宽70 cm、深30 cm、高20 cm。坡道的长度为1.8 m,倾角为20°。

|

| 图 3 人体运动模式识别数据采集实验 Fig.3 Experimental data collection experiments for human motion pattern recognition |

实验中采用的FSR采样频率为100 Hz,IMU采样频率为200 Hz。测试结束后将所有记录导出到csv文件中。数据文件中每一行是一次实例样本,第1列是采样时间,其余列对应传感器属性值。因为采用6轴IMU传感器(3分量线加速度,3分量角速度),所以一共有30列IMU数据分量。加上8个FSR传感器属性列,则一共有38列的原始数据列。表 1中给出了本次采集数据存放在csv中的属性顺序及采用的属性变量名。

| 列数 | 单位 | 属性 | 备注 |

| C01~C04 | % | fsrL1,fsrL2,fsrL3,fsrL4 | 左脚底压力 |

| C05~C08 | % | fsrR1,fsrR2,fsrR3,fsrR4 | 右脚底压力 |

| C09~C11 | m/s2 | w_accx,w_accy,w_accz | 腰部线加速度 |

| C12~C14 | (°)/s | w_gyox,w_gyoy,w_gyoz | 腰部角速度 |

| C15~C17 | m/s2 | lt_accx,lt_accy,lt_accz | 左大腿加速度 |

| C18~C20 | (°)/s | lt_gyox,lt_gyoy,lt_gyoz | 左大腿角速度 |

| C21~C23 | m/s2 | ls_accx,ls_accy,ls_accz | 左小腿加速度 |

| C24~C26 | (°)/s | ls_gyox,ls_gyoy,ls_gyoz | 左小腿角速度 |

| C27~C29 | m/s2 | rt_accx,rt_accy,rt_accz | 右大腿加速度 |

| C30~C32 | (°)/s | rt_gyox,rt_gyoy,rt_gyoz | 右大腿角速度 |

| C33~C35 | m/s2 | rs_accx,rs_accy,rs_accz | 右小腿加速度 |

| C36~C38 | (°)/s | rs_gyox,rs_gyoy,rs_gyoz | 右小腿角速度 |

为了进行人体运动意图模型训练,本研究采用MatlabAB工具对记录的csv数据进行信号分割和必要的前期处理。

2.2.1 信号分割分割内容包括两个部分。第1部分是将各个运动模式对应数据提取出来并添加上对应动作标签;第2部分是对运动相位进行信号段提取与添加相位标签。

具体分割步骤:1) 对所有属性数据进行等时间轴处理后绘图。对于采样频率不相同的信号列,采用插值处理的方法,将数据进行等长处理。2) 确定与待提取运动模式信号相关的传感器信号及特征点。例如,当人从坐立状态要开始站立时,便可利用人体背部的陀螺仪俯仰角度信号作为参考特征信号来进行信号划分,即通过其变化来辨识和划分这两个运动模式。3) 在上一步中选出的参考信号波形中手动标定出信号转折点坐标。4) 获取记录与特征点相同时间的其它属性列的时间下标。5) 根据记录的时间下标实现对各个运动模式下信号的分割。6) 将提取的信号与对应的标签列合并存储到矩阵中。

如表 2所示,本文分别将静坐、站立、步行、跑步、上楼梯、下楼梯、上斜坡及下斜坡依次添加数字标签为1~8。步态运动相位划分为右脚在前的双脚支撑(RDS),左脚摆动(LS),左脚在前的双脚支撑(LDS)和右脚摆动(RS)的4个步态相位,并依次编号1~4。

| 运动模式 | 编号 | 步态运动相位 | 编号 | |

| 静坐(SI) | 1 | 右脚在前的双脚支撑(RDS) | 1 | |

| 站立(ST) | 2 | 左脚摆动(LS) | 2 | |

| 步行(WK) | 3 | 左脚在前的双脚支撑(LDS) | 3 | |

| 跑步(RN) | 4 | 右脚摆动(RS) | 4 | |

| 上楼梯(SA) | 5 | |||

| 下楼梯(SD) | 6 | |||

| 上斜坡(RA) | 7 | |||

| 下斜坡(RD) | 8 |

在输入模式训练器之前,对原始数据进行如下预处理。

1) 去除异常样本和滤波处理

对于缺失值过多、标准差过小、标准差和均值的比值绝对值过小的属性列被删除。每次实验开始的10 s数据为静态标定数据段,也需从训练样本中去掉。当一种运动模式执行途中插入其它的动作如转身、停止等待等时也需要参考特征波形将其去除。人运动的频率一般为几Hz,所以在进行后续处理之前,首先通过10 Hz的低通滤波器对高频噪声进行过滤处理。

2) 标准化处理

由于信息来源于不同类型的传感器,此处对训练集和测试集同时进行[-1, 1]区间归一化处理。为了消除个体体重差异,对FSR数据也进行了标准化处理。

3) 属性选择/降维处理

为了缩短训练模型所需的时间,防止过度拟合,需将输入样本中和类标识相关性较低的属性去除,消除冗余属性。本研究使用主成分分析方法(PCA)对原始属性列进行组合优化来进行降维,从而减小计算复杂度。本研究设定贡献率为95%。

4) 特征提取

特征是针对信号的一个分割提取。一般采用加一定时间宽度的滑动窗来提取特征。采用加窗方法的缺点是减少了每个窗中的信息量,造成了随机性的增加,每个窗口的分类准确性降低,但是通过使用多个窗口做投票,又增加了系统的鲁棒性。

将处理后的数据利用多传感器信息融合的方法进行如下进一步处理。

3 运动意图识别算法及结果分析本文利用多传感器信息融合的方式实现运动意图的识别。常用的融合方法有4类:估计方法、聚类方法、推理方法和人工智能方法。根据本研究的应用场景,采用推理和人工智能法进行多源信息的融合,最终实现运动意图的识别。正如在1.2节中所述,本研究将意图识别系统地划分为3类:1) 运动模式的识别;2) 运动相位识别;3) 状态切换事件预测。下面采用系统性地对比实验研究,选出各类意图识别合适的算法框架和优化参数。

运动模式识别 建立一个多源信息融合模型一般可分为2个部分:一是选择合适的模型框架;二是利用实验数据对模型中的参数进行整定优化。为了选出一个适合本应用的算法框架,对线性判别分析(LDA)、决策树、KNN(K-nearest neighbors)、SVM和神经网络(NN)这几种机器学习算法进行性能比较。最后通过在算法识别准确性、处理实时性方面综合比较选出适合本应用的一种模式识别算法及优化参数列表。

运动相位识别和状态切换事件预测 多传感器系统中,各信息源提供的信息都具有一定程度的不确定性。本研究采用神经-模糊推理系统,基于这些不确定的传感器信息进行融合,最终实现运动相位的识别和状态切换事件的预测。在后期处理中,充分利用各个运动模式的相位- 事件特点,对异常的运动识别结果进行过滤,最后获得较高的识别准确性及较低的识别延时,从而验证了所选择算法及参数的合理性。

3.1 运动模式分类模型本研究利用Matlab工具构建上述各种模式识别算法,分别在多种参数配置下进行像素层和特征层信息的融合,对识别准确率进行了比较。本文用样本的80%作为训练集,剩余的20%样本作为测试集。采用训练集构建分类模型,再用得到的模型对测试集进行类别标签预测以完成对算法性能的评估。对每个受试者,平均识别准确率S按式(1)计算:

|

(1) |

其中,Nc为正确识别决策数,Nt为总的识别数。为了定量分析相互运动模式之间被错误分类情况,定义混淆矩阵C[2]:

|

(2) |

式(2)矩阵中:

|

(3) |

其中,nij为模式i被错误分类到j的数,ni为模式i的识别总数。因此,非对角元素数值越大,被错分到对应模式的概率越大。

3.1.1 像素层信息融合该融合方法直接在传感器采集到的原始观测信息层上进行融合,所以其优点是保持了较多的原始信息,一般具有较高的识别精度。表 3为进行像素层信息融合后,各种模式分类的识别准确率,其中KS参数是RBF内核函数的一个参数,也称为Gamma参数,影响内核函数的形状和泛化能力。

| 单位: % | |||||||||||||||||||||||||||||

| 分类算法 | 参数 | 识别准确率 | 平均准确率 | ||||||||||||||||||||||||||

| 线性判别 | 87.8 | 87.8 | |||||||||||||||||||||||||||

| 决策树 | 分裂数=100 | 95.2 | 79.4 | ||||||||||||||||||||||||||

| 分裂数=20 | 82.5 | ||||||||||||||||||||||||||||

| 分裂数=4 | 60.4 | ||||||||||||||||||||||||||||

| SVM | 线性核函数 | 97.3 | 99.4 | ||||||||||||||||||||||||||

| 2次多项式 | 100.0 | ||||||||||||||||||||||||||||

| 3次多项式 | 100.0 | ||||||||||||||||||||||||||||

| RBF(KS=1.5) | 99.1 | ||||||||||||||||||||||||||||

| RBF(KS=6.2) | 100.0 | ||||||||||||||||||||||||||||

| RBF(KS=25) | 99.8 | ||||||||||||||||||||||||||||

| KNN | K=1(欧氏距离) | 100.0 | 99.8 | ||||||||||||||||||||||||||

| K=10(欧氏距离) | 100.0 | ||||||||||||||||||||||||||||

| K=10(Cosine) | 100.0 | ||||||||||||||||||||||||||||

| K=100(欧氏距离) | 99.5 | ||||||||||||||||||||||||||||

| NN | 隐层节点数=3 | 78.8 | 92.0 | ||||||||||||||||||||||||||

| 隐层节点数=6 | 97.4 | ||||||||||||||||||||||||||||

| 隐层节点数=10 | 100.0 | ||||||||||||||||||||||||||||

该信息融合方法首先对采集到的原始信息添加移动窗提取一组特征信息,形成特征矢量,然后再输入到各个机器学习算法中进行识别预测。

特征提取滑动窗口的宽度是影响识别性能的一个主要因素。因此,为了系统地研究窗口大小对识别性能的影响,本文分别利用宽度为50 ms、100 ms和150 ms,增量为20%的滑动窗对数据进行了分割,并对每个分割窗提取了3个时域信号特征(最小值、最大值和均方根)进行了模式分类器的训练。表 4分别给出了各个窗宽条件下算法的识别准确率。

| 单位: % | |||||||||||||||||||||||||||||

| 分类算法 | 参数 | 50 ms窗宽 | 100 ms窗宽 | 150 ms窗宽 | |||||||||||||||||||||||||

| 准确率 | 平均值 | 准确率 | 平均值 | 准确率 | 平均值 | ||||||||||||||||||||||||

| 线性判别 | 98.7 | 98.7 | 99.4 | 99.4 | 99.4 | 99.4 | |||||||||||||||||||||||

| 决策树 | 分裂数=100 | 95.6 | 81.6 | 95.4 | 82.6 | 94.5 | 61.4 | ||||||||||||||||||||||

| 分裂数=20 | 85.6 | 86.2 | 89.6 | ||||||||||||||||||||||||||

| 分裂数=4 | 63.7 | 66.2 | 61.4 | ||||||||||||||||||||||||||

| SVM | 线性核函数 | 99.6 | 96.3 | 99.6 | 95.4 | 99.8 | 94.8 | ||||||||||||||||||||||

| 2次多项式 | 100.0 | 99.6 | 99.8 | ||||||||||||||||||||||||||

| 3次多项式 | 99.9 | 99.4 | 99.8 | ||||||||||||||||||||||||||

| RBF(KS=1.5) | 80.9 | 77.9 | 75.4 | ||||||||||||||||||||||||||

| RBF(KS=6.2) | 99.7 | 99.8 | 99.6 | ||||||||||||||||||||||||||

| RBF(KS=25) | 97.4 | 96.3 | 94.3 | ||||||||||||||||||||||||||

| KNN | K=1(欧氏距离) | 99.9 | 95.2 | 99.6 | 94.9 | 99.3 | 91.3 | ||||||||||||||||||||||

| K=10(欧氏距离) | 99.2 | 98.9 | 97.6 | ||||||||||||||||||||||||||

| K=10(Cosine) | 99.5 | 99.0 | 98.0 | ||||||||||||||||||||||||||

| K=100(欧氏距离) | 82.1 | 82.1 | 70.1 | ||||||||||||||||||||||||||

| NN | 隐层节点数=3 | 34.2 | 76.6 | 93.4 | 94.3 | 95.8 | 95.0 | ||||||||||||||||||||||

| 隐层节点数=6 | 98.9 | 98.8 | 93.9 | ||||||||||||||||||||||||||

| 隐层节点数=10 | 96.8 | 90.6 | 95.3 | ||||||||||||||||||||||||||

通过表 4可见,随着加窗宽度的增加,在识别准确性上,大部分算法的识别准确性都有下降,但线性判别算法和SVM算法的性能具有一定的稳定性。为了在保持高识别准确性的同时,提高数据处理的实时性。下面继续在加窗宽度150 ms的基础上进一步进行数据降维操作。考虑到不同类型传感器数据列之间所表达的信息很可能存在重叠现象,本研究继续采用主成分分析PCA法(本研究设置保留原本信息的85%以上)对特征向量进行降维处理后进行模型训练学习与预测。结果见表 5所示。条件是原始数据通过宽度为150 ms,增量为20%的滑动窗对数据进行特征提取,再经过PCA降维处理后进行模型训练与动作识别。如表 3~表 5所示,随着传感器数据抽象程度的变化,SVM算法在识别准确的稳定性方面取得了最好的结果。

| 单位: % | |||||||||||||||||||||||||||||

| 分类算法 | 参数 | 识别准确率 | 平均准确率 | ||||||||||||||||||||||||||

| 线性判别 | 73.9 | 73.9 | |||||||||||||||||||||||||||

| 决策树 | 分裂数=100 | 83.7 | 73.2 | ||||||||||||||||||||||||||

| 分裂数=20 | 75.4 | ||||||||||||||||||||||||||||

| 分裂数=4 | 60.4 | ||||||||||||||||||||||||||||

| SVM | 线性核函数 | 80.8 | 90.9 | ||||||||||||||||||||||||||

| 2次多项式 | 98.3 | ||||||||||||||||||||||||||||

| 3次多项式 | 97.6 | ||||||||||||||||||||||||||||

| RBF(KS=1.5) | 93.9 | ||||||||||||||||||||||||||||

| RBF(KS=6.2) | 95.7 | ||||||||||||||||||||||||||||

| RBF(KS=25) | 79.1 | ||||||||||||||||||||||||||||

| KNN | K=1(欧氏距离) | 96.9 | 89.3 | ||||||||||||||||||||||||||

| K=10(欧氏距离) | 95.2 | ||||||||||||||||||||||||||||

| K=10(Cosine) | 92.4 | ||||||||||||||||||||||||||||

| K=100(欧氏距离) | 72.6 | ||||||||||||||||||||||||||||

| NN | 隐层节点数=3 | 76.9 | 77.8 | ||||||||||||||||||||||||||

| 隐层节点数=6 | 68.4 | ||||||||||||||||||||||||||||

| 隐层节点数=10 | 88.21 | ||||||||||||||||||||||||||||

为了进一步提高识别准确的鲁棒性,本研究采用多数投票的后处理方法。利用5个相邻分析窗口的分类结果来产生更准确的识别结果。

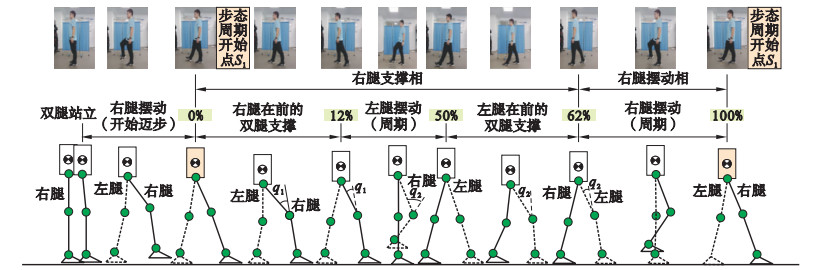

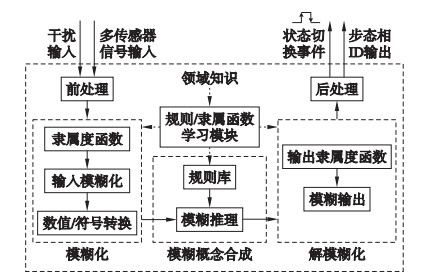

3.2 基于神经-模糊推理系统的相位辨识与预测运动模式相位识别是外骨骼机器人运动规划的一个重要组成部分。如图 4所示,以步态相位划分和识别为例,本研究将一个完整的步态周期分为4个相,即右脚在前的双脚支撑相(RDS)、左脚摆动相(LS)、左脚在前的双脚支撑相(LDS)、右脚摆动相(RS)。因为收到的传感器信息具有一定的模糊性,该任务采用神经-模糊逻辑推理系统来实现。

|

| 图 4 步态相位划分 Fig.4 Gait phase division |

模糊逻辑推理系统结构如图 5所示。模糊逻辑推理过程主要包括对输入信号的前处理操作、模糊化处理、基于模糊推理规则库的模糊概念合成、对模糊输出的解模糊化及后处理五个部分。

|

| 图 5 模糊推理的过程 Fig.5 Process of fuzzy inference system |

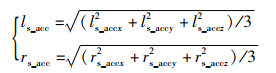

前处理操作与2.2.2节采用相同的处理。传感器数据选择左右脚脚掌和脚跟的4个FSR的信息作为主信号源。为了减少数据处理量,采用式(4) 的方式将左右小腿线性加速度进行合成作为模糊推理系统的两个输入。式(4)中,“l”(left)表示左侧下肢,“r”(right)表示右侧下肢;下标“s”(shank)表示小腿;下标“accx”、“accy”、“accz”分别表示沿x、y、z轴的加速度数据。

|

(4) |

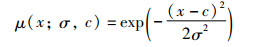

加速度合成信息采用式(5)所示的高斯隶属函数进行模糊化。

|

(5) |

其中,c为曲线顶点的位置值,σ为标准偏差。

4个FSR输入的初始隶属函数选用如式(6)所示的三角隶属函数进行模糊化。

|

(6) |

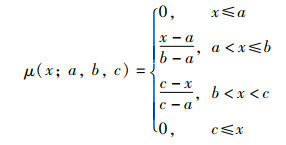

其中,x为4个FSR的压力输入值,a为三角隶属函数第1个值,b为三角隶属函数第2个值,c为三角隶属函数第3个值。模糊化处理后,变成“大”、“中”、“小”的模糊值,经过逻辑推理过程,得到模糊的输出,最后经过解模糊处理得到识别结果。对于模糊逻辑系统,隶属函数的选择以及推理规则对模糊系统的性能以及复杂度都有比较大的影响。本研究采用神经优化算法对各个隶属度函数的参数以及模糊规则库进行优化,从而改善模糊推理系统的性能。图 6给出了优化后的模糊推理系统对步态相位识别的部分结果。

|

| 图 6 神经优化后的隶属函数 Fig.6 Membership function after neural network optimization |

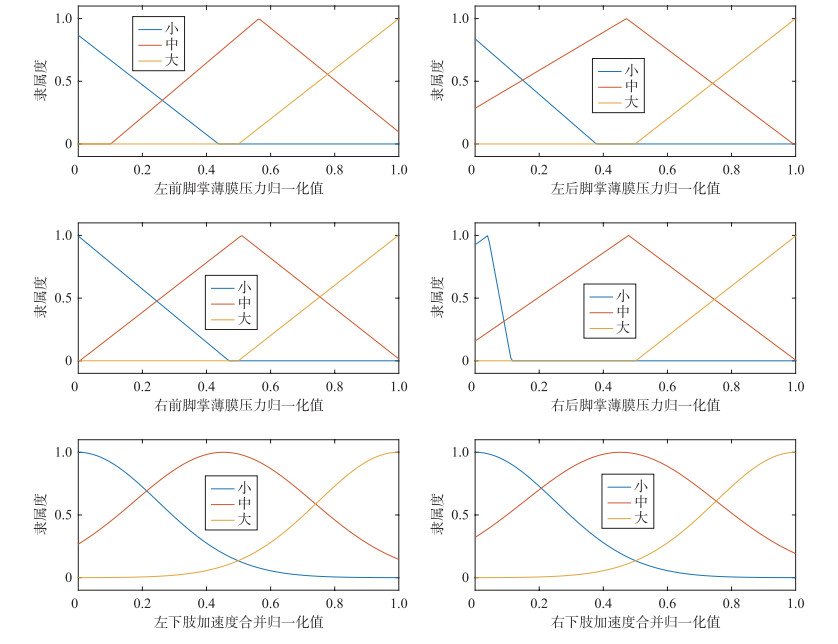

本系统解模糊输出的值经过一定的后处理操作后输出辨识出的运动相ID及状态切换事件脉冲。主要的后处理操作有2个:1) 对输出的ID值进行整数化处理;2) 考虑各个运动相位的时相特点修正相ID值。例如,“右脚摆动相”只能切换到“右脚在前的双脚支撑相”,如若不是则维持前一状态。图 7给出了几个步态周期下预测的相位结果和实际相位的对比图。其中,实际相位曲线是基于脚底压力FSR信号的状态手动分割后绘制的。此处假设该手动获得的相位时刻为理论正确值。图中字符Sx(x=1,2,…)表示步态周期的开始时刻;Ex(x=1,2,…)表示步态周期的结束时刻。

|

| 图 7 运动相及切换事件预测值结果 Fig.7 Prediction results of motion phase and switching events |

为了判断状态转移是否被及时预测,定义预测时间Td:

|

(7) |

其中,tr为状态转移的特征点的真实测量值,tp为通过训练模型首次预测输出的时间点。

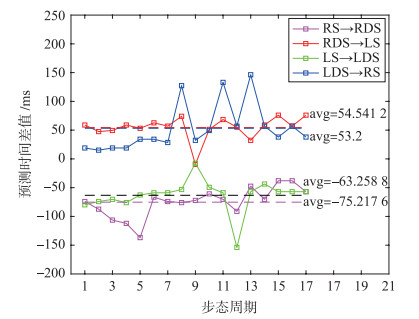

将利用训练好的模糊推理系统进行预测的相位时间结果和实际步态相切换时刻绘图,如图 8所示。由图可知,各步态相位的切换都取得了较好的预测准确性且延时较少,可以满足实时性控制的要求。图中也给出表示预测时间偏差的均值avg(average)曲线和数值。

|

| 图 8 运动状态切换事件预测的时间偏差 Fig.8 Time offset of motion state switch prediction |

3.2节首先介绍了不同的模式识别算法下在测试样本上的运动模式的识别精度,本研究通过两个方面的综合比较,选择SVM算法作为本系统运动的最优算法框架:1) 算法动作识别准确性的稳定性;2) 算法处理的实时性。

3.3.1 运动模式识别根据3.1节可见,虽然像素级数据融合方法保留了尽可能多的原始信息,但不一定可以达到高的识别准确率,如表 3与表 4结果相比,表 4中线性判别和决策树算法获得较高的识别准确率。考虑到算法处理实时性方面,特征层融合方法具有明显的优势,本研究选择特征层多源数据的融合方法进行嵌入式移值。

对于窗宽度的变化,由表 4中对不同加窗宽度识别结果比较可知,随着窗宽度的增加,识别准确率有少许减小,但对线性识别算法和SVM算法,算法稳定性较好且都获得较高的识别准确率。考虑嵌入式数据处理实时性,在保证识别准确率的情况下,处理数据维数越少越好。在相同加窗宽度150 ms的情况下,采用PCA进行降维处理的结果表 4与表 5相比,SVM获得较好的识别精度准确率,平均识别准确率为90.9%,且采用二次多项式的核函数可以获得98.3%的精度,能够达到应用的要求。本系统采用SVM算法来构建分类器。在Matlab中离线获得训练好的SVM模型,将相关的参数保存下来,通过联合编程的方式,将离线训练得到的模型导入在线的运动模式辨识中,并使用多数投票法对辨识结果进行后处理,以进一步提高辨识精度。

在目前样本有限的情况下,比较表 4中SVM各种核函数对识别精度的影响可知,二次多项式都获得最高的识别精度,所以本系统选用二次多项式的核函数。

3.3.2 运动相位辨识根据4.2节图 7结果可知,在目前的测试样本下,利用神经-模糊逻辑推理系统对步态相位预测结果的准确性达到99%。对于运动相位切换事件的预测时间延时,由图 8可知,在测试的17个步态周期中,平均时间差绝对值小于100 ms,而且从摆动相切换到支撑相都实现超前预测(图中负值表示超前,正值代表延迟),从而可以很好地保证外骨骼机器人实现柔顺控制。

4 结论本文以下肢可穿戴式助力外骨骼机器人运动柔顺控制为目的,搭建了实验软硬件系统框架。基于多传感器不同层次信息融合算法,对穿戴者运动意图进行了辨识。对运动意图中的运动模式识别,通过多种模式识别算法(线性判别、树、SVM、KNN、神经网络)在不同数据压缩处理的条件下,在算法的识别准确率及算法稳定性、算法耗时方面进行了综合评价比较。最后得出支持向量机SVM在综合性能上优于其它算法的结论。而且,采用宽度为150 ms,增量为20%的滑动窗对数据进行特征提取,再经过PCA降维处理进行数据压缩来提高数据处理的实时性。

在对细分相位及切换事件的预测方面,本研究采用神经-模糊逻辑推理系统进行。实验结果显示,在目前有限的测试样本下,相位识别准确率为99%,相位切换事件的预测与真实值的偏差平均值在为61.5 ms,满足柔顺控制对预测时间的要求。而且在RDS→LS和LDS→RS之间的切换达到了超前预测的结果,这对进一步实现柔顺控制是非常有益的。

在之后的研究中,拟继续在如下几方面继续深入研究。1) 扩充步态数据库,进一步对算法参数进行调整;2) 算法的嵌入式平台移植及性能评估。

| [1] |

韩亚丽、王兴松、贾山. 下肢助力外骨骼机器人技术[M]. 南京: 东南大学出版社. HAN Y L, WANG X S, JIA S. Lower Limb assisted exoskeleton robotics[M]. Nanjing: Southeast University Press, 2019. |

| [2] |

LIU X, ZHOU Z, WANG Q. Real-time onboard recognition of gait transitions for a bionic knee exoskeleton in transparent mode[C]//40th Annual International Conference of the IEEE Engineering in Medicine and Biology Society. Piscataway, USA: IEEE, 2018: 3202-3205.

|

| [3] |

WANG S, WANG L, MEIJNEKE C, et al. Design and control of the MINDWALKER exoskeleton[J]//IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2015, 23(2): 277-286.

|

| [4] |

BERNHARDT M, FREY M, COLOMBO G, et al. Hybrid force-position control yields cooperative behaviour of the rehabilitation robot LOKOMAT[C]//9th International Conference on Rehabilitation Robotics. Piscataway, USA: IEEE, 2005: 536-539.

|

| [5] |

KAWAMOTO H, TAAL S, NINISS H, et al. Voluntary motion support control of Robot Suit HAL triggered by bioelectrical signal for hemiplegia[C]//2010 Annual International Conference of the IEEE Engineering in Medicine and Biology. Piscataway, USA: IEEE, 2010: 462-466.

|

| [6] |

CB Insights. 2021年全球外骨骼机器人产业研究报告[R/OL]. [2022-02-01]. https://www.dx2025.com/wp-content/uploads/2021/12/cb_insights_.pdf. CB Insights. Global exoskeleton robot industry research report 2021[R/OL]. [2022-02-01]. https://www.dx2025.com/wp-content/uploads/2021/12/cb_insights_.pdf. |

| [7] |

TALATY M, ESQUENAZI A, BRICENO J E. Differentiating ability in users of the ReWalkTM powered exoskeleton: An analysis of walking kinematics[C/OL]//13th IEEE International Conference on Rehabilitation Robotics. Piscataway, USA: IEEE[2022-03-12]. https://ieeexplore.ieee.org/document/6650469. DOI: 10.1109/ICORR.2013.6650469.

|

| [8] |

GHAN J, STEGER R, KAZEROONI H. Control and system identification for the Berkeley lower extremity exoskeleton (BLEEX)[J]. Advanced Robotics, 2006, 20(9): 989-1014. DOI:10.1163/156855306778394012 |

| [9] |

KAZEROONI H, STEGER R. The Berkeley lower extremity exoskeleton[J]. Dynamic Systems, Measurement, and Control, 2006, 128(1): 14-25. DOI:10.1115/1.2168164 |

| [10] |

KAMALI K, AKBARI A A, AKBARZADEH A. Trajectory generation and control of a knee exoskeleton based on dynamic movement primitives for sit-to-stand assistance[J]. Advanced Robotics, 2016, 30(13): 846-860. DOI:10.1080/01691864.2016.1154800 |

| [11] |

孙建, 余永, 葛运建, 等. 基于接触力信息的可穿戴型下肢助力机器人传感系统研究[J]. 中国科学技术大学学报, 2008, 38(12): 1432-1438. SUN J, YU Y, GE Y J, et al. Research on sensing system of wearable lower limb assisted robot based on contact force information[J]. Journal of University of Science and Technology of China, 2008, 38(12): 1432-1438. |

| [12] |

杨秀霞, 杨晓东, 杨智勇. 基于人机系统虚拟样机模型的外骨骼系统控制研究[J]. 机械制造与自动化, 2017, 46(3): 164-167. YANG X X, YANG X D, YANG Z Y. Research on exoskeleton system control based on human-machine system virtual prototype model[J]. Machinery Manufacturing and Automation, 2017, 46(3): 164-167. |

| [13] |

汪亮. 基于可穿戴传感器网络的人体行为识别技术研究[D]. 南京: 南京大学, 2014. WANG L. Research on human behavior recognition technology based on wearable sensor network[D]. Nanjing: Nanjing University, 2014. |

| [14] |

万良金. 基于多传感器信息融合的机器人姿态测量技术研究[D]. 北京: 北京交通大学, 2015. WAN L J. Research on robot attitude measurement technology based on multi-sensor information fusion[D]. Beijing: Beijing Jiaotong University, 2015. |

| [15] |

王永雄, 陈晗, 尹钟, 等. 基于惯导信息的人体动作和路况识别[J]. 生物医学工程学杂志, 2018, 35(4): 621-630. Wang Y X, Chen H, Yin Z, et al. Human motion and road condition recognition based on inertial navigation information[J]. Journal of Biomedical Engineering, 2018, 35(4): 621-630. |

| [16] |

KERN N, ANTIFAKOS S, SCHIELE B, et al. A model for human interruptability: Experimental evaluation and automatic estimation from wearable sensors[C/OL]//Eighth International Symposium on Wearable Computers. Piscataway, USA: IEEE, 2004[2022-02-22]. https://ieeexplore.ieee.org/document/1364705. DOI: 10.1109/ISWC.2004.3.

|

| [17] |

陈启明, 黄瑞. 下肢外骨骼机器人意图识别算法研究[J]. 电子科技大学学报, 2018, 47(3): 330-336. CHEN Q M, HUANG R. Research on intention recognition algorithm of lower limb exoskeleton robot[J]. Journal of University of Electronic Science and Technology, 2018, 47(3): 330-336. DOI:10.3969/j.issn.1001-0548.2018.03.002 |

| [18] |

徐昺. 基于MEMS传感器与Zigbee网络的人体动作捕捉系统的设计与实现[D]. 成都: 电子科技大学, 2013. XU B. Design and implementation of human motion capture system based on MEMS sensor and Zigbee network[D]. Chengdu: University of Electronic Science and Technology, 2013. |

| [19] |

丁其川, 赵新刚, 李自由, 等. 基于自更新混合分类模型的肌电运动识别方法[J]. 自动化学报, 2019, 45(8): 1464-1474. DING Q C, ZHAO X G, LI Z Y, et al. EMG motion recognition method based on self-updating mixed classification model[J]. Journal of Automation, 2019, 45(8): 1464-1474. |

| [20] |

MANCHOLA M, BERNAL M, MUNERA M, et al. Gait phase detection for lower-limb exoskeletons using foot motion data from a single inertial measurement unit in hemiparetic individuals[J/OL]. Sensors, 2019, 19(13)[2022-03-06]. https://www.mdpi.com/1424-8220/19/13/2988. DOI: 10.3390/s19132988.

|

| [21] |

CHEN B, ZHENG E, WANG Q. A locomotion intent prediction system based on multi-sensor fusion[J]. Sensors, 2014, 14(7): 12349-12369. |

| [22] |

HAO M, LIAO W H. Human gait modeling and analysis using a semi-Markov process with ground reaction forces[J]. IEEE Transactions on Neural Systems & Rehabilitation Engineering, 2017, 25(6): 597-607. |

| [23] |

LIM D H, KIM W S, KIM H J, et al. Development of real-time gait phase detection system for a lower extremity exoskeleton robot[J]. International Journal of Precision Engineering and Manufacturing, 2017, 18(5): 681-687. |

| [24] |

LIE Y, JIANBIN Z, YANG W, et al. Adaptive method for real-time gait phase detection based on ground contact forces[J]. Gait & Posture, 2015, 41(1): 269-275. |